Suite à ma conférence donnée le samedi 26 mars 2022 à Bruxelles au skeptics in the pub organisé par le comité para, je reviens dans cet article sur quelques points, dans le but de préciser certaines choses en complément de mon intervention. On va (re)parler de modèles en sciences et en sciences sociales tout particulièrement, en prenant comme exemple le modèle de ségrégation urbaine dû à Thomas Schelling. Ensuite, je reviendrai sur des remarques et des questions qui ont été soumises lors de mon intervention et auxquelles je n’ai pas apporté, à mon goût, de réponse satisfaisante. Il est conseillé de visionner la conférence dans un premier temps afin d’avoir à l’esprit l’entièreté du contexte de la discussion, et en particulier l’ensemble des sources sur lesquelles je m’appuie et que je ne recite pas en détail ici.

Modéliser le social

Le but de ma conférence était de présenter certains contre-exemples à opposer à des arguments souvent entendus pour soutenir le fait que les sciences sociales, et la sociologie en particulier, doivent jouir d’une épistémologie à part. Elles seraient, dans leur essence même, différentes des sciences dites « naturelles » à tel point que les critères épistémologiques habituellement appliqués à ces dernières, par exemple le fameux falsicationnisme poppérien, ne pourraient avoir prise ou de pertinence à l’égard de leur scientificité.

Je ne reviens pas sur ces questions que j’ai déjà exposées un peu plus en détail dans mon intervention. D’autres articles s’y sont d’ailleurs attelés ici-même. Ce qui m’intéresse ici, c’est de revenir sur un des modèles que j’y ai présenté, à savoir le modèle de Thomas Schelling ayant pour but de modéliser certains aspects des processus de ségrégation urbaine.

Le modèle de Schelling

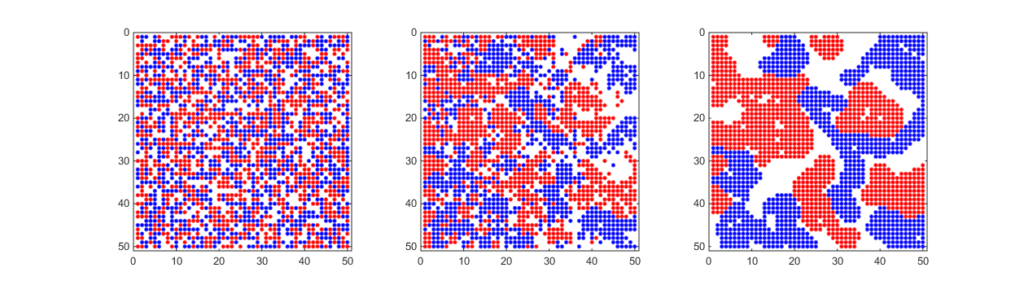

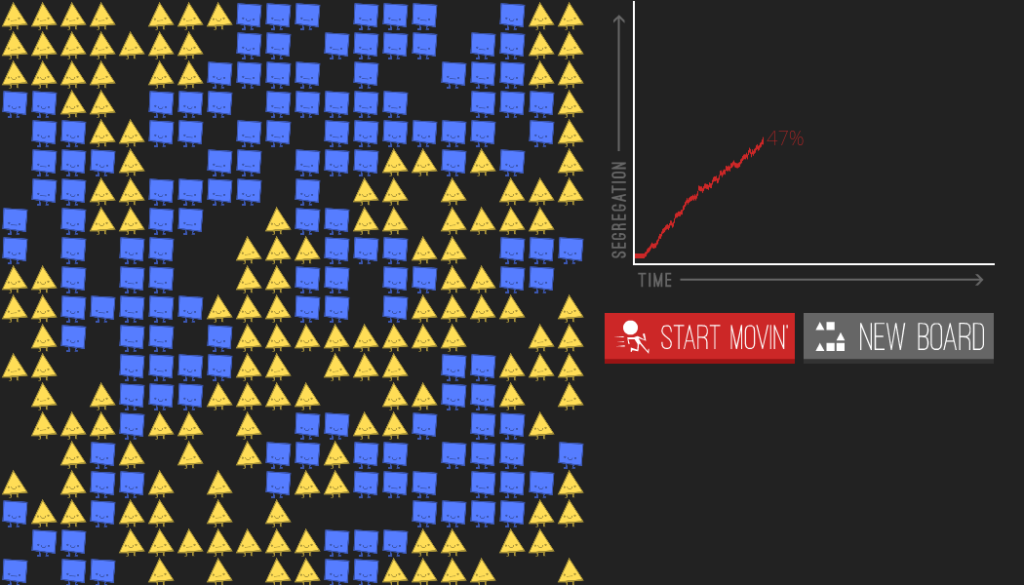

Ce modèle, hautement stylisé, considère un processus dynamique prenant place sur un quadrillage. Sur ce quadrillage, on considère des agents de deux types représentés par deux couleurs (par exemple, rouge et bleu) disposés initialement sans ordre précis, et laissant un certain nombre de cases vacantes. On encode ensuite une dynamique où, à chaque pas de temps, les agents rouges et bleus peuvent changer de place en suivant une règle extrêmement simple. Chaque agent a huit plus proches voisins que l’on appelle son voisinage, ou quartier. On considère que les agents d’une couleur donnée ont un certain degré de tolérance envers les agents de l’autre couleur : chaque agent accepte que son voisinage soit constitué d’un certain pourcentage d’agents d’autres couleurs. Si ce pourcentage est supérieur au seuil de tolérance, alors l’agent « déménage », c’est-à-dire prend, sur le quadrillage, la place vacante la plus proche qui le satisfait de nouveau. Or, en ayant déménagé, il a légérement changé le quartier d’où il est parti tout autant que le quartier où il est arrivé, ce qui a pour conséquence de modifier l’état dans lequel se trouvent les occupants de ce quartier : le seuil de tolérance de certains agents présents dans ces quartiers a peut-être été dépassé. S’en suit une réaction en chaine.

(Crédit : https://github.com/b3rnoulli/schelling-segregation-model)

En simulant cette dynamique pour un grand nombre de pas de temps, on observe la chose suivante : même avec un seuil de tolérance relativement élevé, par exemple 70% (ce qui signifie que chaque agent accepte d’être entouré jusqu’à 70% d’agents de l’autre couleur), en partant d’une situation où tous les agents sont disposés au hasard, on obtient inéluctablement une forte ségrégation. Ce qui veut dire que, selon ce modèle, même des individus assez tolérants peuvent, sans même s’en rendre compte, prendre des décisions individuelles qui, une fois agrégées les unes avec les autres, finissent par produire une forte ségrégation au niveau macro-social. D’autre part, on observe aussi que si le seuil de tolérance est très bas, donc si on a des individus très peu tolérants, alors on obtient une situation assez instable où la ségrégation est, paradoxalement, très faible : les individus qui arrivent quelque part sont si peu tolérants qu’ils déménagent rapidement, avant qu’ait pu se former un voisinage leur ressemblant assez pour qu’ils restent.

Un peu d’épistémologie des modèles

Ce modèle, comme tous les modèles, est stylisé à l’extrême et repose sur des hypothèses loin de recouvrir l’ensemble des réalités dont on a connaissance au sujet des phénomènes de ségrégation. Par exemple, les seuls facteurs intervenant dans la dynamique du processus sont les décisions des individus qui habitent la ville, réduits à des couleurs dans une case, et ne reposant que sur un choix binaire (rester/déménager) commandé par un seuil de tolérance. Beaucoup d’aspects, comme les politiques publiques en termes d’aménagement, parfois elles-mêmes ségrégationnistes, le marché de l’immobilier ou encore les décisions des propriétaires (parfois eux-mêmes racistes) ne sont pas implémentées dans ce modèle. En gardant en tête ces limites – et tout modèle, de la physique quantique à la génétique des populations, a ses limites – le modèle de Schelling nous dit-il tout de même quelque chose d’intéressant ?

Un modèle est une représentation simplifiée de la réalité et ce que l’on perd en détail, on le gagne en manipulabilité. En d’autres termes, il y a une sorte d’équilibre entre, d’une part, un niveau de détails que l’on veut atteindre, et d’autre part la facilité avec laquelle on peut le manipuler et donc lui faire dire des choses. Pensez à une carte géographique : si la carte est trop complexe, par exemple si c’est la carte d’une région et qu’elle représente chaque rue de toutes les villes de la région, cette complexité va empiéter sur ce que l’on va pouvoir faire de la carte, c’est-à-dire sur l’aide cognitive qu’elle va nous apporter pour nous repérer. Si elle est trop simple, alors elle sera plus facilement manipulable, mais, bien sûr, on pourra faire moins de choses avec. Par exemple, on saura que telle ville est au dessus de telle autre et qu’il faut prendre cette route pour les relier, par contre une fois arrivée dans la ville il faudra utiliser une autre source d’information pour trouver, par exemple, la meilleure pizzéria. Dans tous les cas, même si elle est très simple, l’important est qu’elle parvienne à capturer un certain aspect du monde et de ses mécanismes. L’équilibre à trouver entre complexité et manipulabilité dépend entièrement de ce que l’on veut faire avec ce modèle, c’est-à-dire quel aspect du monde on souhaite qu’il nous rende intelligible – et jusqu’à quelle précision. On sait que les hypothèses sur lesquelles il repose sont parcelaires et manquent de nombreux détails qui pour d’autres raisons sont extrêmement importants à prendre en compte, et une erreur serait de tomber, en physique comme en sociologie, dans un réalisme naïf qui nous fait directement prendre nos modèles pour ce à quoi ressemble la réalité que l’on tente d’approcher.

Pour revenir au modèle de Schelling, ce qui intéressant est que, justement, même dans le cas où des hypothèses pouvant expliquer plus directement la ségrégation (comme par exemple le racisme de certains propriétaires) ne sont pas prises en compte et qu’au niveau micro-social les agents seraient d’accord pour qu’il n’y ait pas de ségrégation, une ségrégation apparaît inéluctablement. Ce qu’il nous montre, ce n’est évidemment pas la réalité dans toute sa complexité – car, en fait, aucun modèle ne fait une telle chose. Utiliser ce modèle et en parler, ce n’est pas non plus nier que d’autres facteurs jouent également dans le phénomène de ségrégation – à moins d’être d’une extrême naïveté épistémologique ou bien de vouloir faire dire à ce modèle des choses qu’il ne dit pas, dans le but, par exemple, de minimiser des politiques racistes. Non, modéliser la ségrégation avec le modèle de Schelling, c’est simplement analyser le problème comme une composition de plusieurs phénomènes conjugués et extraire l’un de ces phénomènes supposés pour le modéliser à part. En regardant ce que ce simple phénomène produirait comme effet – ici un effet dit « pervers » où le résultat macro-social va à l’encontre des opinions ou des attentes micro-sociales – il nous apporte une information importante. Au niveau méthodologique, un modèle n’est ni plus ni moins qu’un guide cognitif, des planches en bois posées sur le sable mouvant de la réalité pour nous aider à la regarder de plus près.1

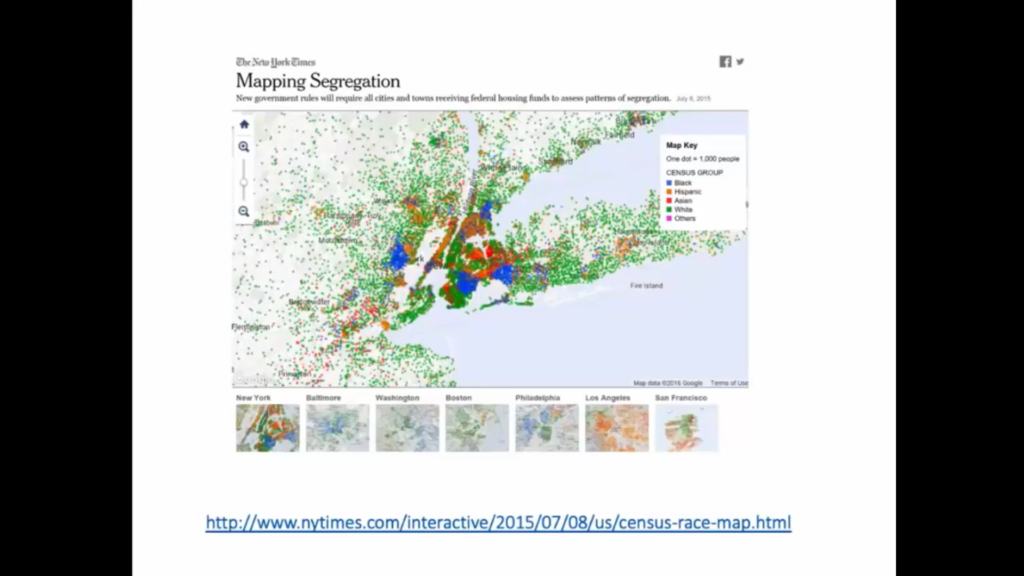

Notons que ce modèle possède par ailleurs un certain succès empirique, puisqu’aux États-Unis où la ségrégation raciale a été très étudiée, il apparaît que le niveau de tolérance au niveau individuel augmente au cours du temps alors qu’une ségrégation urbaine élévée se maintient encore aujourd’hui.

Ce type de modèles et d’approches du monde social se reconnaît sous le vocable de « sociologie analytique », un ensemble de programmes de recherche assez peu connus en France – où la sociologie repose plus traditionnellement sur une approche holiste. Notons que le processus d’idéalisation en sociologie n’est absolument pas nouveau puisque la notion de type idéal, qui recouvre bien cette idée de décrire une réalité complexe en en stylisant à l’extrême certains aspects, remonte à Max Weber (1920). 2

Ce n’est pas de la sociologie

Je voudrais maintenant aborder un type de commentaires que l’on m’a adressé pendant la conférence et auquel je voudrais donner ici une réponse un peu plus claire. Ce type de commentaires, le voici :

« C’est sympa, mais ce n’est pas de la sociologie ».

J’ai présenté dans ma conférence un exemple de résultat typique de l’approche mécanistique propre à la sociologie analytique : on parvient à reproduire une régularité empirique portant sur la distribution des votes lors d’élections proportionnelles dans de nombreux pays différents et à différentes époques – ce qui est déjà en soi un résultat intéressant – en modélisant simplement l’influence sociale de proche en proche à l’aide d’un modèle en réseaux. À chaque nœud du réseau, représentant un individu, l’influence qu’il peut avoir sur les personnes avec qui il est en contact est modélisée par une certaine probabilité de les convaincre de voter pour tel ou tel candidat. En mettant la bonne distribution de probabilité (de forme classique pour ce type de phénomènes), on reproduit effectivement la distribution finale des votes observée macroscopiquement.

On m’a fait la remarque que ce n’était pas de la sociologie, mais de la théorie des réseaux – c’est-à-dire un simple modèle mathématique. Or, certains éléments de ce modèle possèdent une signification empirique, c’est-à-dire font référence à des grandeurs mesurables. Certes, le phénomène est expliqué au sein d’un cadre où l’on a accepté de manière a priori certaines hypothèses – et en particulier la forme de la probabilité modélisant l’influence sociale de proche en proche sur le réseau. Une explication plus « profonde » consisterait à dériver cette hypothèse à partir d’autres hypothèses appartenant à la sociologie ou à la psychologie cognitive, par exemple. Mais ça n’en reste pas moins une explication sociologique puisqu’en supposant cela, on redérive de manière non triviale une observation empirique portant sur le monde social. On pourrait faire le parallèle avec les modèles en mécanique newtonienne : on modélise un phénomène à l’aide d’un ensemble de forces qui s’exercent sur un système, mais la forme même de ces forces n’est adoptée que parcequ’elles parviennent ainsi à redériver un certain nombre d’observations empiriques. Pour autant, ils restent des modèles explicatifs – c’est simplement que l’explication est adossée à un certain cadre que l’on doit se donner a priori, contenu dans ce que Imre Lakatos appelait le noyau dur des théories. Le modèle cité plus haut n’est donc pas un simple modèle de la théorie des réseaux, mais le modèle d’un phénomène social, puisqu’il contient des éléments qui ont une signification empirique et qui portent sur le monde social (ici, le nombre de votes qu’un candidat obtient, le nombre de candidats dans sa liste, etc.) De la même façon, par exemple, que la théorie de la relativité générale n’est pas simplement de la géométrie lorenztienne (le cadre mathématique dans lequel cette théorie est écrite) puisqu’elle contient des hypothèses de correspondance entre des éléments de ses modèles et des éléments observables empiriquement.

Il se trouve que l’on peut dériver certains résultats empiriques portant sur un aspect du monde social sans faire référence – ou alors d’une manière minimale – aux intentions des individus prenant part au processus. Si on regarde la taille des villes en fonction de leur rang, par exemple au sein d’un pays, on tombe quasiment à chaque fois sur la même distribution (dite « en loi de puissance ») qui est typique des phénomènes d’agrégation asymétriques (où des choses s’agrègent et ont plus de probabilité de s’agréger là où quelque chose est déjà agrégé). On retrouve la même distribution pour d’autres phénomènes qui ne sont pas sociaux, comme par exemple les amas d’étoiles. Il est assez étonnant qu’un phénomène comme l’expansion d’une ville, qui en soit fait intervenir un nombre incalculables d’intentions et d’intérêts conflictuels, mais aussi des facteurs non humains, etc. finissent par produire une telle régularité. On m’a alors rétorqué que si un modèle pouvait reproduire un phénomène social sans qu’il n’y ait rien d’humain dedans, c’est-à-dire qui marche même « si c’est pas des humains », alors ce n’était pas de la sociologie.

Il y a deux réponses à apporter ici. Premièrement, le comportement humain est, comme tout le reste, modélisé au sein d’une théorie de l’action servant de support à une explication basée sur l’exhibition de mécanismes microsociaux qui, une fois agrégés, reproduise le phénomène macro-social à expliquer. Il faut, très souvent, modéliser l’action humaine pour que le mécanisme explicatif puisse s’incarner. Certes, cette modélisation est souvent stylisée pour pouvoir être facilement manipulable au sein de modèles, mais il n’en reste pas moins qu’elle existe et est souvent nécessaire (mais parfois, non!) On modélise l’action humaine jusqu’à la finesse nécessaire pour reproduire ce que l’on cherche à reproduire – de la même façon que modéliser une planète comme un point matériel qui ne subit que la force du soleil est une approche très stylisée et qui repose sur des hypothèses que l’on sait, en quelque sorte, fausses, mais cela permet néanmoins de reproduire de manière non triviale un certain nombre d’observations.

Deuxièmement, cet argument, me semble-t-il, dissimule une circularité dans le raisonnement. Devant le constat que l’on peut modéliser certains phénomènes sociaux à l’aide d’une théorie de l’action on ne peut plus minimaliste, dire que ce n’est pas de la sociologie c’est déjà faire le présupposé d’à quoi doivent ressembler les explications en sociologie, donc cela ne permet pas d’écarter logiquement ce type d’explications (à base de modèles) puisque c’est la prémisse de laquelle ce raisonnement démarre. Si on part du principe que les explications en sociologie ne peuvent pas reposer sur des mécanismes fondés sur des modélisations stylisées de l’action inviduelle, alors face aux inombrables contre-exemples offerts par la sociologie analytique, on ne peut sortir de la circularité qu’en remettant en question ce principe. En effet, peut-être que les phénomènes sociaux, malgré la grande complexité avec laquelle ils peuvent nous apparaître, sont, dans certains de leurs aspects, modélisables bien plus simplement que ce que l’on croyait. C’est bien l’une des caractéristiques de la science de nous être parfois si subversive en ce qu’elle bouscule nos a priori et certainement nos croyances à propos de notre caractère si spécial en tant qu’humain et du fait que le social ne saurait être – même en partie – dompté par aucun modèle.

Conclusion : tout est modèle

Pour conclure, je pense qu’en fait même si on n’utilise pas de modèle aussi stylisé que ce qu’on a présenté, qu’on ne cherche pas à généraliser, qu’on en reste à aller voir en détail ce qui se passe sur le terrain, et que notre but est de décrire aussi précisément que possible ce qu’il s’y joue, il n’en reste pas moins qu’on est toujours en train… de faire un modèle. En effet, malgré le fait que nous sommes des êtres sociaux et que de ce fait le ou la sociologue peut interagir dans un langage naturel avec les sujets de son étude, il n’en reste pas moins que cette interaction est toute sauf « directe ». En effet, outre que la présence de l’ethnologue modifie l’objet même de sa recherche et qu’il existe un grand nombre de biais possibles bien connus de la profession, décrire une situation c’est déjà la styliser inmanquablement. Tout simplement parce que les mots que nous utilisons réfèrent à des catégories proprement humaines et à des concepts qui ne sont rien d’autres que des généralisations – par définition – idéaliséees. Un concept est déjà modélisateur. Une enquête de terrain, nécessaire à la connaissance sociologique, c’est déjà le modèle de quelque chose. On a déjà tranché dans la réalité sociale, on l’a déjà immanquablement simplifiée. On ne peut à aucun moment la connaître qu’à travers le cadre conceptuel que l’on se donne.

On ne peut donc récuser une approche basée sur des modèles (au sens de la sociologie analytique) sur le seul principe qu’ils simplifient la réalité, puisqu’il semble proprement impossible de faire autrement. Bien sûr, on peut montrer qu’ils la simplifient trop. Cela ne peut néanmoins pas reposer sur nos a priori d’à quoi elle devrait ressembler, puisque c’est justement nos modèles qui peuvent nous le dire en dernière instance ! Non, le seul juge reste la confrontation avec les données empiriques et les autres modèles concurrents. Cela et uniquement cela peut nous indiquer si la simplification a été trop un peu trop raide ou bien, le cas échéant, qu’elles en sont ses limites.

- La question se pose de savoir si certains aspects de nos modèles font effectivement référence à des éléments d’une réalité objective et si nous pouvons déduire ce fait à partir du constat de leur grande efficacité à rendre compte du réel observable. Cette question est celle du réalisme scientifique. Nous n’abordons pas cette épineuse question ici et nous supposons qu’elle est relativement indépendante : aborder ainsi méthodologiquement l’utilisation des modèles ne présuppose aucun réalisme ou anti-réalisme scientifique.

- On peut même trouver des traces de cette notion et de son utilisation dans les sciences sociales dans des écrits antérieurs à Max Weber, par exemple chez Montesquieu ou encore Tocqueville. Un historique plus complet de la notion et de ses utilisations peut être trouvée dans l’article de Jacques Coenen-Huther : Le type idéal comme instrument de la recherche sociologique, Revue Française de Sociologie, 2003.