Avec « Pilules roses », la philosophe de la médecine Juliette Ferry-Danini nous livre son enquête édifiante sur un scandale entourant le Spasfon, et plus généralement le phloroglucinol, sa molécule active. Faisant partie des médicaments les plus prescrits et vendus (principalement) en France, et en majorité à des femmes, il se trouve qu’il n’a pourtant jamais fait la preuve de son efficacité selon les critères méthodologiques qui sous-tendent de nos jours la mise sur le marché d’un produit de santé. Les origines de cette situation d’ignorance ainsi que les conditions de son maintien dans le temps sont multiples, mais mettent au jour des défaillances tout autant épistémologiques qu’éthiques, le tout profondément imprégné d’un sexisme systémique dont l’institution médicale, des essais cliniques eux-mêmes jusqu’aux professionnels de santé en passant par les campagnes de publicité de l’industrie pharmaceutique, constitue la courroie de transmission.

L’ouvrage débute avec une image très parlante et pédagogiquement puissante de la façon avec laquelle les différents types de connaissances et de pratiques en médecine s’encapsulent les unes dans les autres : des boites gigognes, à l’intérieur desquelles s’entremêlent à la fois des questions épistémologiques (qui ont trait aux connaissances et à leur justification) et des questions éthiques (qui ont trait à ce qu’il convient moralement de faire). La boite qui contient toutes les autres, la plus visible, représente la façon avec laquelle le ou la professionnel-le de santé va informer son ou sa patient-e pour mener à une décision de santé éclairée. Elle dissimule toutes les autres boites, non moins importantes. D’abord, comment un-e professionnel-le de santé s’informe sur les différents médicaments à disposition et sur les données soutenant (ou pas) leur efficacité. Puis, comment ces données sont elles-mêmes produites. Cette dernière question en renferme deux autres : comment mener des essais cliniques sans produire de souffrance inutile et, finalement, à quelle méthodologie un essai clinique doit-il se plier, et pourquoi. Cette vision en boites gigognes donne sa structure à l’ouvrage, où chaque question est abordée l’une après l’autre. En plus d’être une étude de cas à propos du scandale entourant le Spasfon, il constitue donc également une très riche introduction à des questions plus générales concernant l’institution biomédicale dans son ensemble, du laboratoire de recherche au cabinet de consultation. Dans cet article, nous en présentons de manière très résumée certains aspects en particulier, mais le but étant de vous donner envie d’aller lire le livre, sachez que nous sommes loin d’être exhaustifs.

L’origine du problème

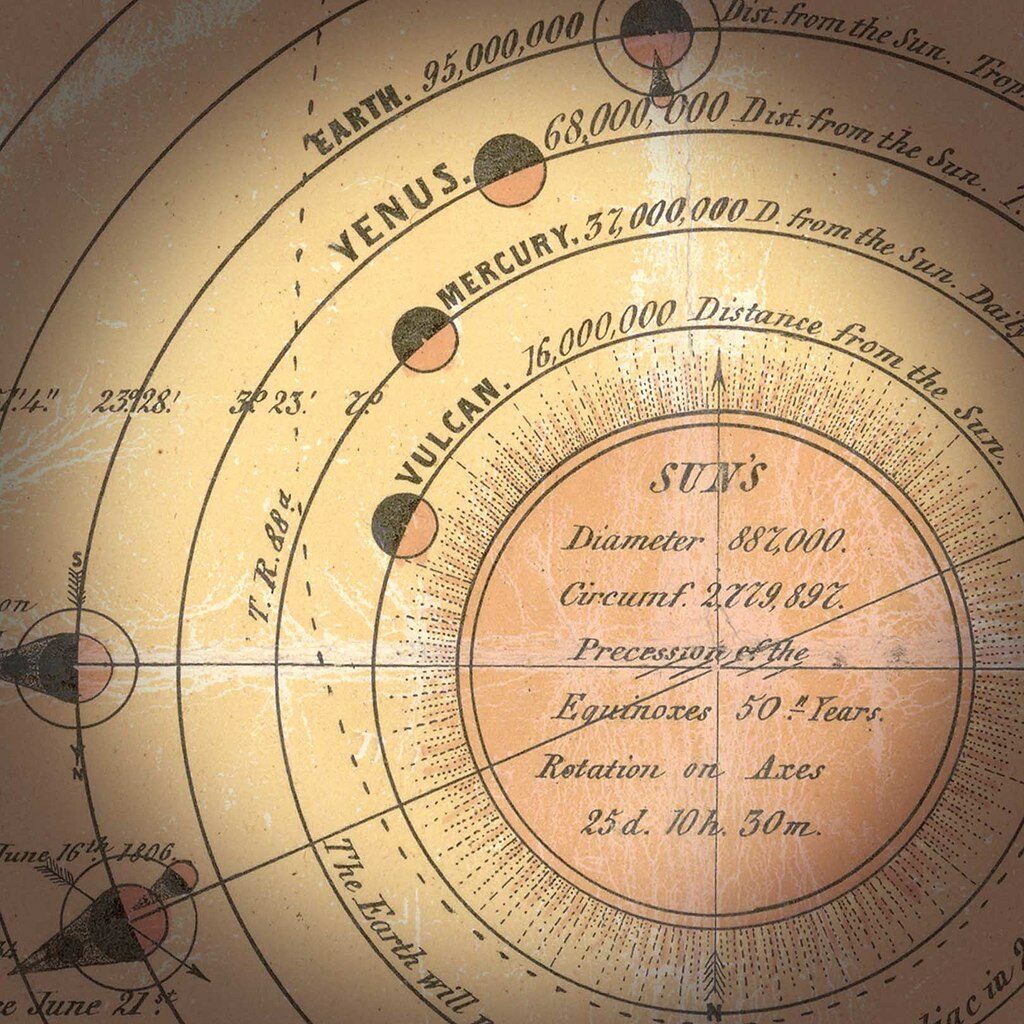

Tester un médicament, ça coûte de l’argent et ça prend du temps, deux éléments qui étaient pourtant à disposition (et plus qu’il n’en faut) des différentes entreprises qui ont commercialisé le Spasfon depuis sa mise sur le marché. En effet, commercialisé depuis les années 60, il est rapidement devenu un énorme succès industriel. C’est à mettre en rapport avec le nombre extrêmement faible d’études cliniques produites depuis plus d’un demi-siècle – sans parler de celles, encore plus rares, qui respectent une méthodologie un tant soit peu rigoureuse. Il semble qu’au moment de sa mise sur le marché, le médicament n’avait été testé que sur une poignée de personnes, dont une majorité de femmes, et qu’il ait profité d’un certain laxisme, probablement parce que les pathologies qu’il était censé traiter étaient dès le départ considérées comme principalement féminines. A cette époque, les contraintes pour mettre sur le marché un médicament étaient certes moins fortes qu’aujourd’hui mais, d’une part, cela n’a jamais été régularisé par la suite alors que des essais cliniques auraient pu être réalisés – et auraient du être exigés de la part des autorités – et, d’autre part, certaines expérimentations (où il s’agissait, en particulier, de provoquer volontairement des douleurs) ont été pratiquées alors qu’elles violaient des principes éthiques fondamentaux, même pour l’époque. La philosophe se fait alors historienne et met au jour des archives de l’époque pour appuyer son propos de manière convaincante.

Les mécanismes de maintien de l’ignorance

Pour comprendre comment une telle situation d’ignorance caractérisée a pu émerger et surtout se maintenir aussi longtemps, différents éléments sont à prendre en compte. En plus des essais cliniques déjà peu convaincants, d’autres études censées appuyer l’efficacité du Spasfon portaient en réalité uniquement sur des mécanismes biologiques (perçus comme) plausibles, ce qui constitue un niveau de preuve très faible en regard des standard actuels, loin derrière les essais contrôlés randomisés et les méta-analyses, par exemple – d’autant plus que certains de ces mécanismes étaient supposés agir sur les « spasmes » et les calmer, phénomènes dont l’existence même est très controversée. En réalité, comme le souligne l’autrice, il ne s’agirait probablement que d’un mythe comme il en existe d’autres autour du fonctionnement physiologique féminin, rappelant par exemple la fameuse « hystérie » psychanalytique, et dont une conséquence importante est la minimisation des ressentis – et en particulier de la douleur – des femmes. Un problème reposant sur un mythe, donc, ainsi qu’une solution toute trouvée pour le résoudre, toute aussi mythique mais qui peut pourtant convaincre par sa simplicité.

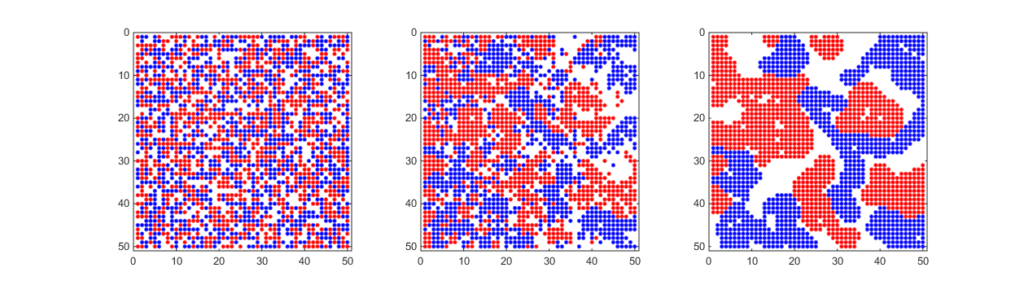

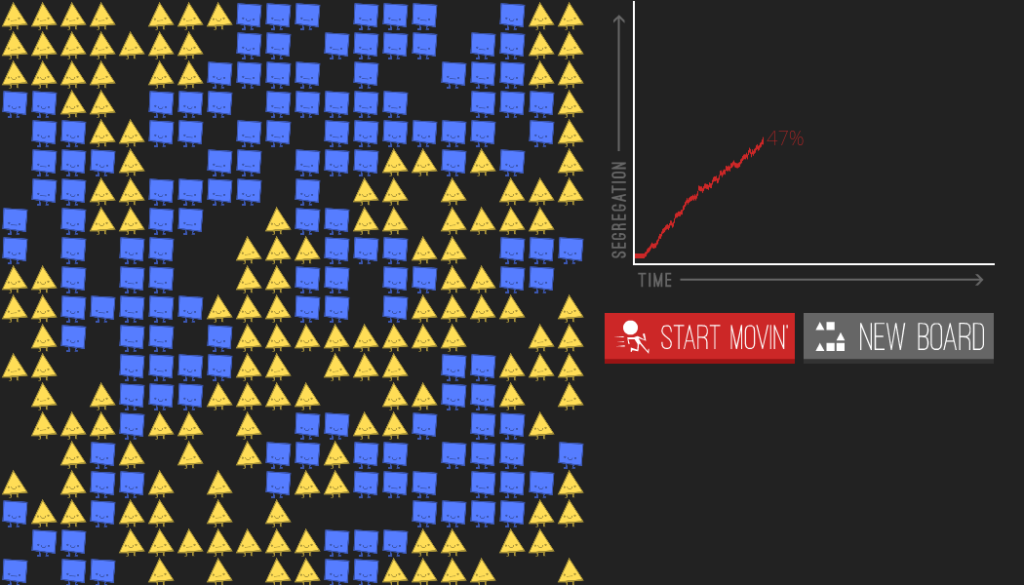

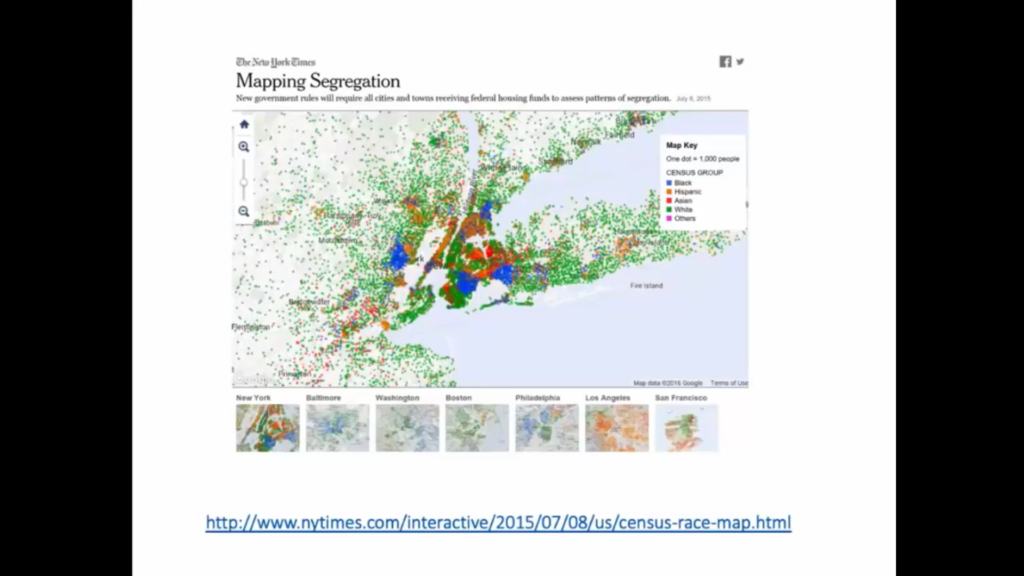

On voit un biais sexiste à l’œuvre déjà à au moins deux endroits ici : dans le laxisme concernant les conditions de la mise sur le marché d’un médicament censé prévenir ou soulager des maux perçus comme principalement féminins, et dans les conditions même de justification de l’efficacité d’un traitement, quand bien même celle-ci repose déjà sur des bases très fragiles. Mais ce n’est pas fini. Il reste également à expliquer comment le succès du Spasfon a pu se maintenir dans le temps en dépit de son inefficacité probable – il est également affaire de discriminations et de présupposés sexistes ici. Imaginez que vous vouliez faire de votre médicament un succès commercial. Une fois qu’il est mis sur le marché, vous pouvez faire de la publicité pour convaincre directement les patients et les patientes de son efficacité, mais c’est long, coûteux, sans certitude que cela soit vraiment efficace. Vous pouvez aussi, et c’est la stratégie que l’autrice s’attache à décrire ici, concentrer vos efforts sur les professionnel-les de santé, par exemple en payant très cher le fameux « office de vulgarisation pharmaceutique » pour faire inscrire votre médicament dans le dictionnaire pharmacologique de référence (en France) : le Vidal, ou bien pour qu’il fasse votre publicité directement auprès des professionnel-les de santé. (Ici, nul besoin de supposer un quelconque lavage de cerveau : simplement contrôler l’information disponible et la façon avec laquelle on la perçoit est beaucoup plus efficace.) Ensuite, une fois que celleux-ci sont enclin-es à prescrire votre médicament en masse, le fait qu’en général les patients et patientes font confiance aux professionnel-les de santé qu’ils et elles consultent fera le reste. De plus, concernant les traitements visant à soulager la douleur chez les femmes, le fait que les professionnel-les de santé ont tendance à minimiser systématiquement celle-ci permettra également de protéger votre médicament de la réfutation de son efficacité : si la patiente n’a plus mal, c’est bien la preuve que votre médicament est efficace ; si elle a encore mal, c’est probablement « psychologique », ou dû au fait que « les femmes ont tendance à exagérer leur douleur », rien à voir avec l’inefficacité de votre médicament. Ainsi, le risque est minime qu’on cherche à le remettre en question en produisant, par exemple, de nouvelles études cliniques. L’ignorance à la base du problème se reproduit donc d’elle-même – et le tout s’auto-entretient.

Il faut bien sûr prendre ceci pour ce que c’est : un modèle, forcément simplifié, d’un mécanisme possible de reproduction des discriminations expliquant le maintien dans le temps d’un tel produit de santé sans efficacité propre. Pour autant, il capture déjà des aspects essentiels du processus. Pour une vision plus fouillée et complète, nous vous invitons bien sûr à lire l’ouvrage.

Secret de Polichinelle et éthique du placebo

Finalement, il apparaît que l’inefficacité du Spasfon serait plus ou moins un secret de polichinelle chez les professionnel-les de santé. Comme montré dans le livre, beaucoup le savent très bien ou du moins s’en doutent fort, et pourtant continuent de le prescrire. Nul besoin de supposer qu’iels sont payé-es directement par l’industrie pharmaceutique pour ça : encore une fois, l’inertie de l’habitude couplée d’une rationalisation du type « les patientes sont habituées » ou « dans tous les cas on peut jouer sur l’effet placebo, ce qui ne fait jamais de mal », suffit à expliquer cette situation. Et justement, c’est sur ce dernier point – l’utilisation des placebos en médecine – que l’autrice clôture son ouvrage. Elle se prononce en effet en défaveur de leur utilisation, pour plusieurs raisons en accord à la fois avec les recommandations issues des meilleures méta-analyses sur les effets supposés de l’administration d’un placebo et sur des travaux fondamentaux en éthique du biomédical, dont elle est d’ailleurs spécialiste. Allant à l’encontre d’une idée reçue (qui semble intuitive de prime abord) souvent entendue en défense des traitements qui n’ont pas fait la preuve de leur efficacité spécifique, elle montre que non, l’administration d’un placebo n’est pas (toujours) sans danger. D’une part, il peut y avoir des effets directs de l’administration d’un placebo, notamment lorsque celui-ci est « impur » – c’est-à-dire qu’il y a un principe actif, c’est juste qu’on a de bonnes raisons de penser que ce principe n’agit pas sur la pathologie que l’on veut traiter. Quant aux placebos purs (qui ne contiennent aucun principe actif), les meilleures études sur le sujet montrent que l’effet placebo a été surestimé pendant des décennies, et qu’en réalité, quand il existe, il est assez faible, trop faible pour apporter un bénéfice thérapeutique substantiel – vous ne pouvez pas guérir grâce à un placebo, mais son administration couplée à certains éléments de contexte thérapeutique peut avoir un effet sur certains de vos symptômes, comme par exemple la douleur. Mais d’autre part, il y a aussi des effets indirects : certains médicaments prescrits comme « placebo » peuvent être achetés sans ordonnance, et donc la croyance dans leur efficacité peut mener à de l’automédication, éloigner les personnes de traitements efficaces et donc diminuer leurs chances d’être soignées correctement. De plus, du point de vue éthique, administrer un placebo à un ou une patient-e à son insu c’est aller contre leur consentement, puisqu’iels ne sont alors pas en mesure de prendre une décision éclairée. De nouveau, nous vous invitons à lire l’ouvrage pour une présentation bien plus riche et détaillée des raisonnements sous-jacents à cette discussion.

Conclusion

Puisant à la fois dans l’épistémologie, la philosophie, l’éthique, l’histoire et la sociologie de la médecine, l’ouvrage de Juliette Ferry-Danini apparaît donc incontournable pour toute personne désireuse d’aiguiser son esprit critique sur la production, la diffusion et l’application des connaissances en médecine. Celles-ci, d’un point de vue féministe, ne semblent pas pouvoir se départir de leurs conditions sociales et culturelles d’émergence où les logiques patriarcales et mercantiles, comme souvent, vont de pair dans la production et le maintien d’une ignorance stratégique.