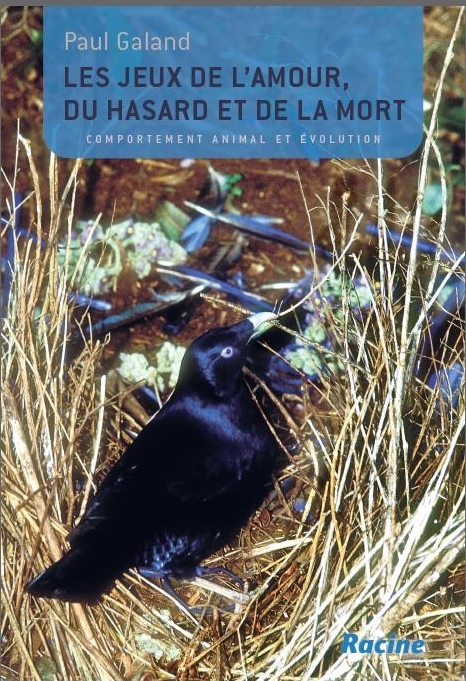

A paru en 2011, aux éditions Racine, Les jeux de l’amour, du hasard et de la mort. Comprement animal et évolution sous la plume alerte de Paul Galand de l’Université Libre de Bruxelles, docteur en sciences zoologiques et agrégé d’université.

Je viens de le lire, que dis-je, de le dévorer. Farci d’exemples aussi truculents que roucoulants, avec des anecdotes qui font exploser de rire toutes les dix pages, Paul Galand introduit avec finesse les processus évolutifs, circonscrits les erreurs classiques, illustre les mécanismes de tamis des comportements du vivant avec les exemples les plus invraisemblables qui soient, certains sordides à souhait.

Partant des gamètes, de la semence, des ovulations, P. Galand explore les différentes « manières » que les espèces ont « développées » pour « assurer » leur descendance – ou que leur génome respectif, pourrait-on dire, a « emprunté » pour « assurer » sa propre reproduction.

Version sans guillemets (et sans téléologisme) : P. Galand explore les différents résultats des processus évolutifs qui ont donné lieu à des espèces relativement stables et encore en vie.

Avec prudence, il balise les termes de « leurre », « ruse », « stratégie » ou « intention », évitant ainsi la chausse-trappe d’un dessein « intelligent » dans des mécanismes qui n’en ont pas du tout besoin. Hormis le rôle du sourire du bébé, il n’y a par contre pas d’introduction vers les mécanismes purement humains, ou vers de la mémétique (1) introductive, et ça m’a un peu manqué.

17 x 24 cm

320 pages € 22,50

Éditions Racine : écrire à sandrine.thys@racine.be ou au 02/646 44 44.

(1) La mémétique est une discipline qui se propose d’utiliser le concept d’objet culturel, le mème, pour faire une lecture évolutive darwinienne de la culture

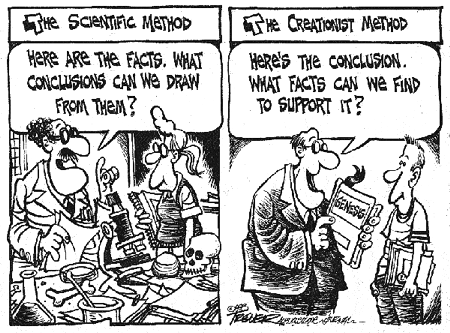

On ne s’attardera pas sur les créationnismes « négationniste » et « mimétique ». Ils se fondent sur le récit de la création de l’univers dans les grands textes monothéistes, pris de façon littérale. Les contradictions qui en résultent provoquent une négation des résultats des sciences dans le premier cas, ou bien une « science créationniste » qui établit les prétendues preuves de la vérité littérale du texte dans le second cas. Le premier est notamment représenté par Harun Yahya, pseudonyme de M. Adnan Oktar, homme d’affaires et d’influence turc, qui distribua en janvier 2007 dans toute l’Europe son Atlas de la Création, (auto-édité, Global Publishing) y compris dans les établissements scolaires et laboratoires français. En janvier 2012, via Harun Yahya France, il organisait à Paris, à Rouen et à Évry, une série de conférences : « L’impasse moléculaire de la théorie de l’évolution » « l’effondrement de la théorie de l’évolution »…

On ne s’attardera pas sur les créationnismes « négationniste » et « mimétique ». Ils se fondent sur le récit de la création de l’univers dans les grands textes monothéistes, pris de façon littérale. Les contradictions qui en résultent provoquent une négation des résultats des sciences dans le premier cas, ou bien une « science créationniste » qui établit les prétendues preuves de la vérité littérale du texte dans le second cas. Le premier est notamment représenté par Harun Yahya, pseudonyme de M. Adnan Oktar, homme d’affaires et d’influence turc, qui distribua en janvier 2007 dans toute l’Europe son Atlas de la Création, (auto-édité, Global Publishing) y compris dans les établissements scolaires et laboratoires français. En janvier 2012, via Harun Yahya France, il organisait à Paris, à Rouen et à Évry, une série de conférences : « L’impasse moléculaire de la théorie de l’évolution » « l’effondrement de la théorie de l’évolution »… Or, les créationnismes et spiritualismes cités ont tous un point commun, leur ignorance, réelle ou feinte, de la nature et du périmètre de légitimité de la démarche et du discours scientifiques : ce que les sciences disent, comment elles le disent, ce qu’elles ne disent pas. Quand l’UIP somme les chercheurs de réfléchir aux « conséquences métaphysiques » de leurs découvertes (Le Monde, 23 février 2006) et affirme qu’« un créateur ne peut être exclu du champ de la science », (Le Monde, 2 septembre 2006), elle « oublie » que le propre des sciences n’est jamais de dire ce qu’il faut « croire », mais de démontrer ce qu’il n’est logiquement plus possible de croire. Mais surtout, elle omet de dire si les scientifiques sont appelés à se prononcer sur ces questions à titre individuel, ou à titre collectif. La confusion entraîne le métier de scientifique d’aujourd’hui au delà de sa légitimité. Il s’agit bien là d’une forme de scientisme déguisé. En organisant la confusion entre la quête spirituelle individuelle et le contrat collectif d’une profession, ces offensives peuvent avoir pour effet, à terme, de faire perdre l’autonomie des scientifiques dans la validation des savoirs. En effet, si la profession se voyait collectivement animée d’un agenda métaphysique, il lui faudrait s’attendre à se voir imposé ce qu’il serait conforme de trouver. L’universalisme des connaissances raisonnées, qui tient aujourd’hui précisément à une abstention métaphysique, ne serait plus possible et l’on assisterait à une communautarisation des savoirs.

Or, les créationnismes et spiritualismes cités ont tous un point commun, leur ignorance, réelle ou feinte, de la nature et du périmètre de légitimité de la démarche et du discours scientifiques : ce que les sciences disent, comment elles le disent, ce qu’elles ne disent pas. Quand l’UIP somme les chercheurs de réfléchir aux « conséquences métaphysiques » de leurs découvertes (Le Monde, 23 février 2006) et affirme qu’« un créateur ne peut être exclu du champ de la science », (Le Monde, 2 septembre 2006), elle « oublie » que le propre des sciences n’est jamais de dire ce qu’il faut « croire », mais de démontrer ce qu’il n’est logiquement plus possible de croire. Mais surtout, elle omet de dire si les scientifiques sont appelés à se prononcer sur ces questions à titre individuel, ou à titre collectif. La confusion entraîne le métier de scientifique d’aujourd’hui au delà de sa légitimité. Il s’agit bien là d’une forme de scientisme déguisé. En organisant la confusion entre la quête spirituelle individuelle et le contrat collectif d’une profession, ces offensives peuvent avoir pour effet, à terme, de faire perdre l’autonomie des scientifiques dans la validation des savoirs. En effet, si la profession se voyait collectivement animée d’un agenda métaphysique, il lui faudrait s’attendre à se voir imposé ce qu’il serait conforme de trouver. L’universalisme des connaissances raisonnées, qui tient aujourd’hui précisément à une abstention métaphysique, ne serait plus possible et l’on assisterait à une communautarisation des savoirs.

= dx/dt, l’« accélération » γ = d²x/dt², la « force » F = mγ sont des concepts analytiques quantitatifs parce qu’ils résultent de la combinaison de grandeurs élémentaires mesurables (dans le cas de la vitesse : une certaine quantité d’espace dx et une certaine quantité de temps dt). Au contraire, les « concepts qualitatifs » ne supposent aucune mesure. C’est le cas des concepts de la topologie, comme ceux de « boule » ou d’« anneau de Möbius » (voir ci-contre, l’anneau de Möbius par le graveur Escher).

= dx/dt, l’« accélération » γ = d²x/dt², la « force » F = mγ sont des concepts analytiques quantitatifs parce qu’ils résultent de la combinaison de grandeurs élémentaires mesurables (dans le cas de la vitesse : une certaine quantité d’espace dx et une certaine quantité de temps dt). Au contraire, les « concepts qualitatifs » ne supposent aucune mesure. C’est le cas des concepts de la topologie, comme ceux de « boule » ou d’« anneau de Möbius » (voir ci-contre, l’anneau de Möbius par le graveur Escher).

résultats assez différents de ceux du sondage américain.Il est possible d’imaginer que nos compatriotes se déclareraient plus volontiers darwiniens que leurs voisins d’outre-Atlantique, pourtant il serait sage de rester sceptique face à ces résultats. En effet, pour prendre ce genre de déclarations au sérieux, il faudrait être assuré que le sens commun conçoit clairement ce qu’être darwinien signifie, ce dont il est permis de douter.

résultats assez différents de ceux du sondage américain.Il est possible d’imaginer que nos compatriotes se déclareraient plus volontiers darwiniens que leurs voisins d’outre-Atlantique, pourtant il serait sage de rester sceptique face à ces résultats. En effet, pour prendre ce genre de déclarations au sérieux, il faudrait être assuré que le sens commun conçoit clairement ce qu’être darwinien signifie, ce dont il est permis de douter.