Si nous enseignons des outils d’analyse critique et une méthodologie d’enquête, c’est dans l’objectif de permettre à tout un chacun de se faire une opinion, y compris sur des sujets complexes éloignés de nos champs de compétence. Cette année, avec des étudiants en première année d’IUT Techniques de Commercialisation et à la demande de certains de leurs enseignants, j’ai décidé de me focaliser sur la recherche et le tri d’informations. Je disposais de sept séances d’une heure et demie, et d’un ordinateur par étudiant : il n’en fallait pas plus pour les lancer sur des sujets aussi ramifiés que les controverses sur les organismes génétiquement modifiés (OGM), les risques de la vaccination contre l’hépatite B et la nocivité présumée des lignes à très haute tension. Mes objectifs : que les étudiants soient capables de trouver des informations contradictoires et de croiser ces informations, qu’ils sachent questionner la fiabilité d’une source et remonter à l’origine de l’information, qu’ils sachent repérer les arguments d’autorité et les arguments fallacieux pour qu’à la fin, ils puissent se faire un avis étayé. Voilà comment je m’y suis pris !

Guillemette Reviron

Pour la deuxième année consécutive, je suis intervenue à l’IUT de Béziers auprès d’étudiants de première année. Les étudiants étaient répartis en trois groupes de 28.

L’année dernière, j’avais adapté mes cours de Sciences et auto-défense intellectuelle : j’enseignais les outils sous la forme de cours magistraux et les étudiants devaient réaliser un dossier en petit groupe sur un sujet de leur choix relevant du « paranormal ». Le résultat ne fut pas fameux : je disposais de moins d’heures de cours qu’avec mes étudiants en L2 de sciences, j’avais moins de temps pour suivre des étudiants bien plus nombreux et le thème ne les motivait pas vraiment. Cette année, j’ai donc décidé de fonctionner complètement différemment et d’utiliser l’extraordinaire équipement informatique de l’IUT en lançant les étudiants sur des enquêtes concernant trois grandes controverses scientifiques :

- le groupe A a enquêté sur la nocivité des lignes à très haute tension

- le groupe B a enquêté sur les risques de la vaccination contre l’hépatite B

- le groupe C a enquêté sur la nocivité des organismes génétiquement modifiés (OGM) (nous avons restreint la recherche au cas du maïs OGM NK 603).

Les étudiants ont travaillé en groupes de 3 ou 4, en autonomie, et se sont organisés comme ils l’entendaient. Ils avaient pour mission de se faire un avis étayé sur leur controverse et de réaliser un dossier présentant leur enquête (voir leurs travaux ici). J’ai volontairement choisi trois sujets sur lesquels je n’avais jamais vraiment travaillé auparavant pour limiter mon influence dans leur travail – j’ai plus essayé de les suivre que de les attirer vers certaines sources. Ces thèmes avaient aussi la particularité d’être éloignés a priori de leur champs de compétence, mon but étant de leur enseigner une méthode efficace de recherche, même pour les non spécialistes.

Mon rôle pendant les séances consistait à leur expliquer au gré de leurs trouvailles comment jauger la fiabilité d’une source, à leur présenter quelques outils d’analyse critique et, surtout, à être de très mauvaise foi pour les inciter à tirer toujours un peu plus les fils de leur enquête et à étoffer leur argumentation. Une médecin était l’auteure d’un rapport, je les incitai à vérifier qu’elle n’avait pas de lien d’intérêt avec un laboratoire pharmaceutique. Le site Doctissimo.fr déclarait être une équipe indépendante, une petite phrase sur un site ne suffisait pas à me convaincre – et la poursuite de leur enquête m’a donné raison. Le CRIIGEN est le Comité de Recherche et d’Information Indépendantes sur le Génie Génétique, un simple nom n’a jamais garanti le niveau d’expertise et d’indépendance d’une structure, il fallait fouiller plus. Cela a beaucoup déstabilisé les étudiants : si aucune source n’était complètement fiable, à qui fallait-il se vouer ? Petit à petit, ils se sont familiarisés avec l’idée que l’accumulation d’informations contradictoires, si elle est troublante au début, est nécessaire pour se faire une opinion : il est d’autant plus aisé d’évaluer la fiabilité d’une source ou d’une information qu’on a beaucoup douté et beaucoup fouillé.

J’ai décrit ci-dessous le contenu des séances en détail, et j’ai conclu en présentant les écueils rencontrés.

Séance 1

Je voulais commencer par faire comprendre aux étudiants pourquoi l’information qui nous est livrée dans un média – quel qu’il soit – n’est pas fiable à 100% et qu’il est absolument nécessaire de retourner à la source d’une information, de se renseigner sur les gens qui s’expriment, de croiser les sources, etc.

Avant toute chose, sans rien leur dire de plus que mes nom et prénom, je leur ai demandé de répondre au questionnaire suivant :

Quelle est, selon vous, sur une échelle de 1 à 6, la dangerosité

1. des ondes du micro-onde

2. de l’utilisation quotidienne du téléphone portable

3. de l’exposition quotidienne au wifi

4. des OGM pour la santé humaine

5. des lignes à très haute tension

6. des antennes relais

7. de la vaccination ROR

8. de la vaccination contre l’hépatite B

(Je n’ai pas encore eu le temps de dépouiller les questionnaires. J’indiquerai ici les résultats dès que cela sera fait)

Ensuite, j’ai projeté à chaque groupe un reportage de quelques minutes sur leur sujet (sans rien leur dire de plus).

Groupe A – La nocivité des lignes à très haute tensions (THT) a-telle été mise en évidence ? – Extrait du Journal Télévisé de France 3 Nord (11 octobre 2011)

Lignes_THT_danger _France3Nord_11_10_2011

Groupe B – Un lien de causalité entre la vaccination contre l’hépatite B et la sclérose en plaque a-t-il été mis en évidence ? – Reportage sur une exposition de peinture réalisée par une association de victimes du vaccin contre l’hépatite B, sur TVTours (2009)

Exposition_des_victimes_du_vaccin_hépatite_B_on_en_parle_TVTours_2009

Groupe C – La nocivité des OGM pour l’humain a-t-elle été mise en évidence ? Cas du maïs OGM NK 603. Reportage intitulé L’autorisation du maïs de Monsanto suscite l’inquiétude, ITélé (2 août 2013)

OGM_l_autorisation_du_mais_Monsanto_suscite_l_inquietude_02_08_13_9h47

Je leur ai ensuite demandé leur avis sur la vidéo et j’avoue avoir été assez surprise par leur réaction ; étant donné le point de vue alarmiste pris dans les reportages, je m’attendais à ce que les étudiants s’insurgent sur les dangers auxquels on les exposait. Pourtant, ils ont tout de suite critiqué la mise en forme de l’information, le tri des intervenants, parfois leur statut, le peu de place laissé à la parole contradictoire… Quand je leur ai demandé si le reportage leur permettait de se faire un avis, tous les étudiants qui ont pris la parole étaient unanimes : non, ils n’étaient pas assez informés. J’ai donc attrapé la balle au bond : quand je leur avais demandé de répondre au questionnaire, aucun étudiant n’avait refusé de répondre en se déclarant incompétent. Ils avaient tous exprimé un avis sur chacun des huit points. D’où leur venait donc cet avis ? Avaient-ils travaillé sur le sujet, étaient-ils spécialistes de la question ? Il leur fallut concéder qu’ils s’étaient forgé leur avis à travers les médias, en regardant le même type de reportages que celui qu’ils venaient de critiquer.

Ce fut l’occasion de discuter sur la différence entre un simple avis ou un acte de foi et une opinion étayée, de la nécessité de se méfier de ce qui nous paraît (in)vraisemblable, du biais de confirmation d’hypothèse, du niveau de preuves requis face à un phénomène extra-ordinaire, de l’impossibilité logique à démontrer que quelque chose n’est jamais dangereux, de la charge de la preuve qui incombe à celui qui prétend.

Je leur ai présenté le travail que je leur demandais et j’ai conclu cette séance avec le TP sur l’affaire Bintou-Le Point et le fait, qu’à notre connaissance, le journaliste Jean-Michel Décugis n’a jamais été sanctionné pour ne pas avoir vérifié ses sources : nous avons évoqué les contraintes temporelles du journaliste, la scénarisation de l’information, la formation souvent généraliste des journalistes, leur statut souvent précaire, autant de choses qui empiètent sur la qualité de l’information donnée.

Séance 2

Les étudiants disposaient chacun d’un ordinateur avec un accès internet.

Je leur ai demandé, pour cette première étape de recherche,

1. De faire de courtes recherches sur l’hépatite B et son vaccin / les lignes THT / les OGM – de quoi s’agit-il ? Que leur reproche-t-on ? Quel marché cela représente-t-il ? Quelles sont les alternatives ? Quelle est la législation française ?…

2. D’identifier les acteurs du débat, sans se préoccuper de leurs arguments, si ce n’est de repérer s’ils sont plutôt pour ou plutôt contre.

3. De donner le statut de ces acteurs : scientifique (quels titres ? quelle structure ?), victimes, témoins, association, laboratoire de recherche, institutions gouvernementales, institutions internationales…

Au début, les étudiants recensaient comme « acteurs du débat » des médias généraux (Libération, Le Monde, Le Figaro, Rue 89…) ou Wikipédia. Il m’a fallu revenir sur les constats de la séance précédente pour qu’ils se rappellent pourquoi on ne pouvait s’appuyer sur ce type de sources. Ceci dit, dans les articles qu’ils découvraient, les journalistes citaient des individus, des institutions, des associations… Ils n’avaient qu’à les recenser.

Techniquement, les étudiants ont passé beaucoup de temps à lire les articles d’un bout à l’autre ; je leur ai donc expliqué qu’on pouvait, à cette étape initiale, se contenter de parcourir rapidement le texte pour en extraire la seule information qui nous intéressait : qui est cité ?

J’ai souvent dû couper les étudiants qui, pour me faire part d’une de leur trouvaille, commençaient par « ils disent que », « sur ce site, j’ai trouvé que… ». L’objectif de la séance n’était pas d’analyser le discours mais d’identifier les acteurs du débat. Qui dit ? Qui est derrière ce site ? Répondre à ces questions est essentiel pour évaluer par la suite le degré d’expertise de l’intervenant.

Séance 3

L’objectif de la première partie de cette séance était de cerner les enjeux du débat. Si la mission des étudiants est de se faire un avis sur la dangerosité de certaines applications technologiques, la controverse ne se fait pas uniquement sur ce point. Je voulais qu’ils se fassent une idée des autres axes de la polémique, ne serait-ce que pour repérer quand un débat sur la dangerosité est détourné vers un autre aspect du problème (esthétique, financier, non respect d’un choix individuel ou collectif, lobbying, conflit d’intérêt…)

La deuxième partie de leur recherche devait s’orienter vers les critiques sur la fiabilité des intervenants. Ils ont choisi quatre ou cinq des principaux acteurs du débat et ont enquêté plus en détail : conflits d’intérêts, vérification des titres exacts, reproches qui leur sont faits par leurs contradicteurs et vérification des dires, évènements passés qui peuvent engendrer un doute sur leur fiabilité ou leur niveau d’expertise…

Du point de vue méthodologique, j’ai dû intervenir sur plusieurs points :

1. Si l’on cherche des critiques sur une institution, il n’est pas très efficace de la chercher sur son propre site

2. Faire attention aux arguments d’autorité (institut, comité de recherche…). Je leur ai donné l’exemple du CorteX (un collectif de recherche sans statut juridique jusqu’à cet été). Je leur ai également expliqué que n’importe qui peut créer une association, qu’aucune justification de l’expertise des protagonistes n’est demandée.

3. Mettre plusieurs mots dans le moteur de recherche est plus efficace. On peut commencer par « critique Organisation Mondiale de la Santé » ou « critique OMS », lire les titres des articles sélectionnés dans lesquels apparaissent des mots clés plus précis (lobbying, fraude, conflit d’intérêt…) et réinjecter ces mots dans le moteur de recherche (OMS « conflit d’intérêt »). Pour se perfectionner sur la recherche d’informations sur internet, on pourra consulter cette page.

4. Lorsqu’on tombe sur une page ou sur un long rapport, une manière d’accéder rapidement au passage qui nous intéresse consiste à taper le nom de la structure dans la fenêtre ouverte en cliquant sur Rechercher dans la page

4. Toujours noter qui critique

5. J’ai expliqué ce qu’était un conflit d’intérêt et qu’une telle accusation, pour être pertinente, devait être ciblée et sourcée (par exemple, en démontrant qu’une personne précise salariée par un laboratoire pharmaceutique était également auteur d’un rapport de l’Organisation Mondiale de la Santé (OMS) sur les risques de la vaccination contre l’hépatite B). Dans le domaine de la santé, la déclaration de conflit d’intérêt potentiel est obligatoire pour tout médecin qui s’exprime à propos d’un produit pharmaceutique ; si on ne la trouve pas, il est toujours possible de contacter la personne évoquée et de lui demander où se trouve sa déclaration

Séance 4

J’ai proposé aux étudiants de lire deux articles du CorteX. Le premier, Vulgarisation – Le jeu des 20 pièges, comment éviter les arguments d’autorité ?, avait pour objectif de récapituler ce que nous avions entrevu de manière informelle sur les arguments d’autorité au gré de leurs recherches. Le deuxième, le Petit recueil de 18 moisissures argumentatives pour concours de mauvaise foi, était une manière de les préparer à la deuxième partie de la séance : recenser et jauger les arguments des différentes parties.

La consigne était de faire l’inventaire des arguments avancés par les différentes parties en notant sur quel type de sources elles s’appuient (un témoignage, de nombreux témoignage, une enquête citoyenne, une étude scientifique, une méta-analyse etc.)

Séance 5

Les étudiants ont continué la recension des arguments avancés par les différentes parties. Ce travail leur a paru plus difficile que les étapes précédentes. Ils ont eu du mal à discerner ce que j’appelais la source d’un argument et avaient tendance à s’arrêter à des affirmations du type « l’étude d’untel et untel démontre que… ». Je les ai donc poussé à chercher et obtenir les études/rapports/enquêtes/etc. correspondants.

Ils ont aussi été déstabilisés par les affirmations non sourcées, basée sur des arguments d’autorité, comme « des chercheurs américains ont démontré que… ». Je pense qu’ils craignaient d’être pénalisés s’ils ne trouvaient pas la source. Je leur alors rappelé que la charge de la preuve incombe à celui qui prétend : le fait que l’affirmation ne soit pas sourcée est une information en soit.

Séance 6

Pour les deux dernières séances, j’avais prévu de leur faire analyser une ou deux sources en particulier : enquête sur les auteurs (s’ils n’avaient pas déjà enquêté sur eux) et initiation à la critique de la méthodologie (taille de l’échantillon, tri des données a posteriori, critique de questionnaires d’enquête, etc.). Cependant, comme de nombreux groupes avaient pris du retard, nous avons utilisé cette séance pour revenir sur certains points, en particulier, la recherche des sources des différentes parties (enquêtes citoyennes, études scientifiques, rapport ministériels, rapport d’agences, témoignage(s), etc.).

Séance 7

Pour cette dernière séance, j’ai demandé aux étudiants de choisir une des sources trouvées précédemment, de la lire et d’en faire une analyse critique. Bien sûr, analyser une seule source ne suffit pas pour prétendre avoir fait le tour du sujet, mais je voulais saisir l’occasion de discuter avec eux sur le fait que la conclusion d’une étude ne peut être prise en compte qu’à partir du moment où la méthodologie employée est sans défaut. Pour l’enquête sur le maïs OGM NK 603, la plupart des groupes ont choisi l’étude de G.-E. Séralini dont beaucoup d’analyses sont disponibles sur le net. Les groupes qui ont travaillé sur la nocivité des lignes à très haute tension ont majoritairement étudié une enquête du CRIIREM élaborée à partir de questionnaires, ce qui nous a permis d’aborder les limites de ce type d’études. Ils ont cherché et trouvé les questionnaires et devaient également se renseigner sur la manière dont ces questionnaires avaient été distribués et rendus. La question était de savoir s’il y avait un tri des données était possible. Comme d’habitude, il m’a fallu rappelé que si cette information n’était pas disponible, cela n’était pas de la responsabilité des étudiants mais qu’ils devaient le signaler comme une faille dans la description de l’enquête.

Dans le groupe sur les risques de la vaccination contre l’hépatite B, les sources choisies ont été plus variées. Certains ont choisi une étude publiée dans un journal scientifique (et se sont aperçus que cela n’est pas forcément un gage de sérieux), d’autres des témoignages.

Les écueils rencontrés

Le travail en groupe et la mauvaise organisation des étudiants

Les étudiants ont travaillé en groupe, mais ont eu du mal à se répartir le travail. Ils ont choisi, pour la plupart, de se répartir les différentes parties du plan. Le premier travaillait sur l’introduction, le deuxième sur les enjeux du débat, le troisième sur les acteurs du débat, etc. Malgré mes incitations récurrentes à travailler ensemble sur chaque partie (comment chercher les arguments d’une des parties si on n’a pas répertorié les différentes parties en présence ?), les étudiants se sont obstinés dans leur manière de faire. Je n’ai pas trouvé de solution pour les faire changer d’avis et de pratique.

La limite de temps

Le projet était ambitieux et le temps limité. J’ai dû revoir mes prévisions à la baisse et j’ai par exemple renoncé à leur projeter à la fin de leur enquête le reportage visionné lors de la séance 1. C’était pourtant une manière de mesurer l’impact de leur travail sur leur analyse du message médiatique.

J’ai également dû restreindre le nombre de sources analysées, ce qui est un problème aussi bien pour l’apprentissage de la méthodologie que pour la pertinence de leur conclusion.

Les consignes mal comprises

Les étudiants ont eu du mal à comprendre ce que j’attendais d’eux à chaque séance. Ils sont très nombreux à m’avoir dit que c’était très éloigné de ce qu’on leur avait demandé jusqu’ici. J’ai donc passé beaucoup de temps à recadrer les groupes les uns après les autres, individuellement, et certains groupes avec qui j’ai passé moins de temps en ont pâti. Il faudrait peut-être prévoir pour chaque séance une fiche explicative, avec des exemples simples et concrets (fils trop peu tirés, type d’informations que l’on recherche, l’endroit où elles se trouvent, etc…)

Dossiers des étudiants

Groupe A – La nocivité des lignes à très haute tensions (lignes THT) a-telle été mise en évidence ?

Groupe B – Un lien de causalité entre la vaccination contre l’hépatite B et la sclérose en plaque a-t-il été mis en évidence ?

Groupe C – La nocivité des OGM pour l’humain a-t-elle été mise en évidence ? Cas du maïs OGM NK 603

Dans un premier temps, j’ai introduit un support, une vidéo d’un clip de la Commission Européenne de mars 2012 visant à promouvoir l’élargissement auprès des jeunes. La vidéo est restée quelques heures en lignes et a fait scandale car on y voit une jeune femme blanche (habillée comme Uma Thurman dans le film Kill Bill, de Q. Tarantino) se faisant agresser par des guerriers chinois, brésiliens et indiens maniant chacun un art martial national. Pour se défendre la jeune femme se dédouble jusqu’à former un cercle autour des guerriers les invitant à la négociation. Le slogan est : « the more we are, the stronger we are » : plus nous sommes nombreux, plus nous sommes forts.

Dans un premier temps, j’ai introduit un support, une vidéo d’un clip de la Commission Européenne de mars 2012 visant à promouvoir l’élargissement auprès des jeunes. La vidéo est restée quelques heures en lignes et a fait scandale car on y voit une jeune femme blanche (habillée comme Uma Thurman dans le film Kill Bill, de Q. Tarantino) se faisant agresser par des guerriers chinois, brésiliens et indiens maniant chacun un art martial national. Pour se défendre la jeune femme se dédouble jusqu’à former un cercle autour des guerriers les invitant à la négociation. Le slogan est : « the more we are, the stronger we are » : plus nous sommes nombreux, plus nous sommes forts.

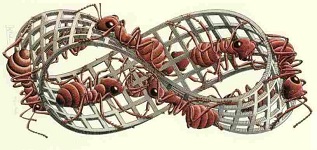

= dx/dt, l’« accélération » γ = d²x/dt², la « force » F = mγ sont des concepts analytiques quantitatifs parce qu’ils résultent de la combinaison de grandeurs élémentaires mesurables (dans le cas de la vitesse : une certaine quantité d’espace dx et une certaine quantité de temps dt). Au contraire, les « concepts qualitatifs » ne supposent aucune mesure. C’est le cas des concepts de la topologie, comme ceux de « boule » ou d’« anneau de Möbius » (voir ci-contre, l’anneau de Möbius par le graveur Escher).

= dx/dt, l’« accélération » γ = d²x/dt², la « force » F = mγ sont des concepts analytiques quantitatifs parce qu’ils résultent de la combinaison de grandeurs élémentaires mesurables (dans le cas de la vitesse : une certaine quantité d’espace dx et une certaine quantité de temps dt). Au contraire, les « concepts qualitatifs » ne supposent aucune mesure. C’est le cas des concepts de la topologie, comme ceux de « boule » ou d’« anneau de Möbius » (voir ci-contre, l’anneau de Möbius par le graveur Escher).

résultats assez différents de ceux du sondage américain.Il est possible d’imaginer que nos compatriotes se déclareraient plus volontiers darwiniens que leurs voisins d’outre-Atlantique, pourtant il serait sage de rester sceptique face à ces résultats. En effet, pour prendre ce genre de déclarations au sérieux, il faudrait être assuré que le sens commun conçoit clairement ce qu’être darwinien signifie, ce dont il est permis de douter.

résultats assez différents de ceux du sondage américain.Il est possible d’imaginer que nos compatriotes se déclareraient plus volontiers darwiniens que leurs voisins d’outre-Atlantique, pourtant il serait sage de rester sceptique face à ces résultats. En effet, pour prendre ce genre de déclarations au sérieux, il faudrait être assuré que le sens commun conçoit clairement ce qu’être darwinien signifie, ce dont il est permis de douter.