Le critère de réfutabilité est bien connu dans le milieu zététique : élément clé permettant de distinguer sciences et pseudosciences, il est pourtant plus difficile à manier qu’il n’y paraît. Afin d’éviter que le corps astral de Karl Popper ne se retourne dans son plan cosmique sépulcral, notre collègue Jérémy Attard nous aide à nous y retrouver, rappelant les bases de ce concept majeur d’épistémologie, puis en pointant les écueils à contourner lorsqu’il est question de le vulgariser.

Simplifier, sans déformer

Dans notre enseignement de la zététique nous avons souvent coutume de déclarer : « Une proposition irréfutable n’est pas scientifique ! » ce qui pourrait sous-entendre qu’une telle proposition ne mérite pas notre attention. Nous entendons par « proposition irréfutable » indistinctement les propositions du type « demain il va pleuvoir ou bien il ne va pas pleuvoir » comme celles du genre « oui, certes, on a des photos de la Terre vue de l’espace, mais c’est des montages de la NASA pour nous cacher que la Terre est plate ! » Le premier cas correspond à une proposition vraie indépendamment de l’expérience et donc qui n’a pas beaucoup de chance de nous apporter une quelconque information substantielle sur le monde ; le second est un cas bien connu d’immunisation contre la réfutation consistant à rajouter une hypothèse ad hoc pour sauver une thèse à laquelle on tient. Lorsque nous parlons de ce critère de réfutabilité, nous faisons évidemment référence à l’éminent philosophe des sciences Karl Popper qui l’a établi et popularisé dans les années 1930 [1]. Cependant, de même qu’il ne viendrait à l’idée de personne, a priori, de présenter l’effet placebo tel que décrit dans la première méta-analyse de Henry Beecher en 1955 sans tenir compte des travaux plus récents qui le remettent assez profondément en question, il nous semble étrange de résumer l’épistémologie, et notamment la réfutabilité, à Karl Popper sans prendre en compte ce qu’il s’est passé après lui. Il ne s’agit pas, dans un enseignement de zététique consacré aux bases épistémologiques, de faire un cours à proprement parler d’épistémologie, bien entendu. Il s’agit simplement de glisser quelques nuances, qui apporteront un peu de profondeur au problème sans pour autant nous perdre dans des considérations stratosphérico-métaphysiques désincarnées des besoins d’outils pratiques de celles et ceux venu-e-s nous écouter.

Il s’agit, d’abord, de réaliser une meilleure vulgarisation que celle que nous faisons. Dans toute démarche de vulgarisation, il y a un équilibre subtil à trouver entre la simplicité du propos, dans un but pédagogique de transmission, et sa solidité scientifique. Ce que l’on gagne en simplicité, on le perd très souvent en rigueur et inversement. Ce que nous proposons ici est une façon de présenter le critère de réfutabilité qui améliore cet équilibre par rapport à la façon dont il est habituellement enseigné. N’oublions pas que comprendre le critère de réfutabilité est un objectif pédagogique avant tout : donner un outil simple d’utilisation pour identifier rapidement, au moins dans un premier temps, ce qui distingue une science d’une pseudoscience. Mais une trop grande simplification, pour toute pédagogique qu’elle soit, peut se retourner contre son but initial si l’on ne transmet pas en même temps l’idée que « c’est un peu plus compliqué que ça » ainsi que des pistes pour aller chercher plus loin.

En effet, si l’on creuse un peu l’histoire des sciences d’une part, et la philosophie des sciences d’autre part, on se rend rapidement compte de deux choses : 1/ les théories les plus scientifiques sont fondées sur des propositions irréfutables ; 2/ le fait d’ajouter des hypothèses pour « sauver » une théorie constitue la majeure partie du travail des scientifiques. Une fois ces deux faits établis, et donc mis à jour le caractère un peu « léger » de notre critique usuelle de l’irréfutabilité, nous verrons comment l’améliorer sans trop d’efforts et ainsi ne plus tendre l’homme de paille1 pour nous faire battre. En effet, une personne défendant un contenu pseudoscientifique et un tant soit peu au fait de l’histoire ou de la philosophie des sciences pourrait nous rétorquer que la science, telle qu’on la présente, fonctionne en réalité de la même manière (et elle n’aurait pas tort…) C’est aussi l’occasion de donner quelques références supplémentaires en épistémologie si l’on veut aller creuser le sujet.

La théorie peut-elle réfuter l’expérience ?

C’est un fait bien accepté qu’une théorie scientifique doit pouvoir rentrer en contradiction avec l’expérience. Le raisonnement est relativement simple : une théorie scientifique prétend dire quelque chose de non trivial sur le monde, et donc tirer sa validité de l’expérience. Si une théorie est irréfutable, c’est-à-dire si elle ne produit que des énoncés tautologiques, vrais en dehors de toute expérience, sa validité ne va pas être conditionnée par celle-ci. L’expérience est pourtant in fine la seule manière que l’on a de rentrer en contact avec la réalité objective dont on prétend pouvoir obtenir une information fiable. Une théorie qui ne produit que des énoncés tautologiques ou qui est immunisée d’une manière ou d’une autre contre la réfutation ne pourra donc pas obtenir d’information non triviale sur le monde, et ainsi ne pourra pas être considérée comme scientifique. En d’autres termes, ce qui est intéressant lorsque l’on prétend dire quelque chose sur le monde, ce n’est pas simplement d’avoir raison, mais d’avoir raison alors qu’on aurait très bien pu avoir tort : c’est de ce type de validation qu’une théorie tire sa valeur scientifique.

Il faut donc que la théorie ait une possibilité de rentrer en contradiction avec l’expérience. Mais, plus précisément, qu’est-ce qui rentre en contact avec l’expérience, dans une théorie ? Prenons un exemple concret, tiré de la physique : le principe de conservation de l’énergie. Dans le cadre de la physique newtonienne, celui-ci s’énonce de la manière suivante : « L’énergie totale d’un système isolé se conserve », un système isolé étant défini comme un système qui n’échange ni énergie ni matière avec l’extérieur. En gros, l’énergie peut changer de forme au sein du système mais ne peut pas disparaître ou apparaître si le système est isolé. Posons-nous alors la question : est-ce que ce principe est réfutable par l’expérience ? On a envie de dire oui, à première vue : si l’on observe un système qu’on a de bonnes raisons de considérer comme isolé et dont l’énergie totale augmente ou diminue, alors on pourrait dire que l’on a réfuté ce principe. Pourtant, penser de cette façon est une erreur à la fois au regard de l’histoire que de la philosophie des sciences. En effet, historiquement, à chaque fois que ce principe a été remis en question, on ne l’a jamais abandonné : on l’a au contraire considéré comme vrai a priori, ce qui a poussé les physicien-ne-s à inventer de nouvelles entités ou des nouveaux phénomènes (par exemple, des formes d’énergies ou des particules inconnues jusqu’alors) pour « sauver » ce principe contre l’expérience : la théorie peut en quelque chose parfois réfuter l’expérience2.

Et cette méthode a très souvent porté ses fruits puisqu’elle a conduit à la découverte de Neptune, des forces de frottements, des neutrinos ou encore du boson de Higgs : dans chacun de ces cas précis, face à une réfutation par l’expérience, on a imaginé des hypothèses pour expliquer pourquoi l’expérience ne collait pas avec ce que l’on avait prédit, tout simplement parce que la solidité de la théorie était posée comme une certitude acquise au vu de ses nombreux succès expérimentaux précédents. On trouvera de nombreux exemples de cette façon de fonctionner en particulier dans les travaux de Thomas Kuhn. Celui-ci, dans son ouvrage majeur [2], décrit en effet l’activité « normale » du ou de la scientifique comme étant la résolution de problèmes au sein d’un paradigme donné. Les « problèmes » dont il s’agit ne sont donc absolument pas considérés, de ce point de vue, comme des réfutations de la théorie dans son ensemble, mais simplement comme des anomalies qu’une reconfiguration de la théorie doit pouvoir absorber. Les anomalies fondamentales, comme celle de l’avancée du périhélie de Mercure, ne sont considérées comme telles que rétrospectivement, et peuvent très bien être parfaitement connues de la communauté scientifique pendant des décennies sans que cela n’implique la remise en question profonde de la théorie sous-jacente.

Du point de vue philosophique, maintenant, cela n’a pas vraiment de sens de considérer qu’un principe fondamental comme celui de la conservation de l’énergie puisse être vrai ou faux : en effet, si face à une contradiction avec l’expérience, on déclare que ce principe est faux, on ne peut plus rien faire ; on n’a pas réglé le problème, on est juste sorti du cadre au sein duquel c’était un problème – ce qui n’est pas du tout la même chose. Par exemple, le problème de l’accélération de l’expansion de l’univers, en cosmologie, est fondamentalement un problème de conservation de l’énergie. Si l’on déclare qu’en fait l’énergie ne se conserve pas, que ce principe est faux, l’accélération de l’expansion n’est plus un problème – son aspect problématique n’existe qu’au sein d’un paradigme où l’énergie se conserve. L’ennui est qu’une fois considéré ce principe comme réfuté, on se retrouve démuni pour faire de nouvelles prédictions, puisque tout ce que l’on avait pour parler de ce pan de la réalité était justement le principe de conservation de l’énergie !

Les programmes de recherche

Ainsi, devant ce double constat, il est intéressant d’affiner ce critère de réfutabilité et d’emprunter à Imre Lakatos, philosophe hongrois et disciple de Karl Popper, la notion de programme de recherche [3]. Pour Lakatos, un programme de recherche est constitué d’une part d’un noyau dur formé de définitions, de principes, de propositions définissant un cadre avec lequel on va investiguer un pan du réel, et d’autre part d’une certaine quantité d’hypothèses auxiliaires desquelles on va déduire, à l’aide des règles du noyau dur, des prédictions qui pourront rentrer en contradiction avec l’expérience. Ce sont ces prédictions-là qui doivent être réfutables, et rien d’autre. Si une prédiction rentre en contradiction avec l’expérience, alors on va modifier des hypothèses auxiliaires afin de résoudre cette contradiction. Un programme de recherche génère alors une suite de théories où l’on passe de l’une à l’autre par un changement d’hypothèses auxiliaires. Le problème, bien sûr, est qu’il y a toujours beaucoup de façons de réajuster notre édifice théorique afin de faire coller une prédiction avec l’expérience3. Karl Popper en est d’ailleurs lui-même bien conscient. Comme l’écrit Lakatos :

« Popper (…) en convient : le problème est de pouvoir distinguer entre des ajustements qui sont scientifiques et d’autres qui sont pseudoscientifiques, entre des modifications rationnelles et des modifications irrationnelles de théorie. Selon Popper, sauver une théorie à l’aide d’hypothèses auxiliaires qui satisfont des conditions bien définies représente un progrès scientifique ; mais sauver une théorie à l’aide d’hypothèses auxiliaires qui n’y satisfont pas représente une dégénérescence. »4

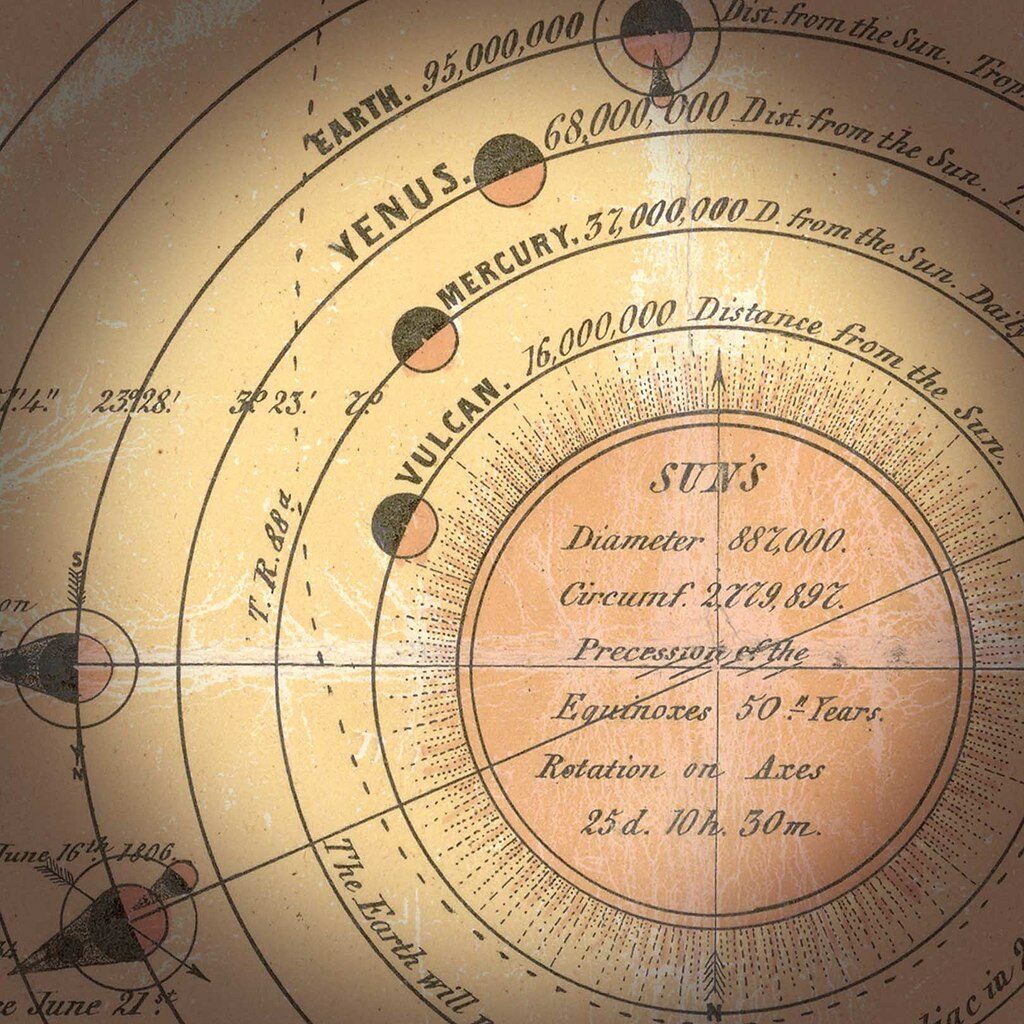

Pour le falsificationnisme méthodologique dont se réclame Karl Popper, on a le droit de rajouter ou de modifier certaines hypothèses suite à une contradiction avec l’expérience si cette modification augmente le niveau de réfutabilité de la théorie, c’est-à-dire si cela nous pousse à faire de nouvelles prédictions indépendantes du fait de simplement résoudre la contradiction initiale. Si ces nouvelles prédictions, réfutables, sont validées, alors on a augmenté notre connaissance sur le monde, et c’était une bonne chose de « protéger » notre théorie de la réfutation par l’ajout d’hypothèses. L’exemple de la découverte de Neptune est parlant. Au début du dix-neuvième siècle, la planète du système solaire la plus lointaine alors connue était Uranus, et il s’est vite avéré que sa trajectoire semblait ne pas se soumettre à ce que la théorie de Newton prédisait. Plusieurs solutions s’offraient aux astronomes de l’époque, comme par exemple admettre que la théorie de Newton n’était plus valable à cette échelle. Cependant, la première explication qui fût considérée était qu’il existait une planète encore inconnue à l’époque, dont l’attraction gravitationnelle sur Uranus rendrait compte de sa trajectoire problématique. L’éminent astronome français Le Verrier5 calcula alors les caractéristiques de cette planète (en supposant qu’elle existait) à l’aide des lois de Newton, c’est-à-dire en les considérant comme valides. Neptune fut effectivement observée en 1846 à l’observatoire de Berlin, et ce qui aurait pu être une défaite de la théorie de Newton finit en réalité par en constituer une victoire de plus. Le programme de recherche, selon Lakatos, est alors dans sa phase progressive. Par contre, dès l’instant où la modification d’hypothèses ne permet pas de faire des prédictions réfutables mais simplement de résoudre la contradiction sans augmenter notre niveau de connaissance sur le monde, on se trouve alors dans une phase dégénérative, et la nécessité d’un nouveau programme de recherche, reposant sur un noyau dur différent, se fait sentir. La difficulté est évidemment qu’au pied du mur, on ne peut jamais savoir avec certitude si l’on est dans un cas où l’on peut encore modifier des hypothèses auxiliaires et augmenter notre connaissance ou bien si l’on est face à une aporie intrinsèque du programme de recherche. Ce n’est que rétrospectivement que la situation s’éclaircit. Dans la continuité de la découverte de Neptune, les astronomes de l’époque avaient aussi conjecturé l’existence d’une autre planète hypothétique, Vulcain, censée se trouvait entre le Soleil et Mercure et expliquait une anomalie, tout aussi bien connue, dans la trajectoire de cette dernière. Pour autant, cette planète ne sera jamais observée6. Il faudra attendre 1915 et la théorie de la relativité générale d’Einstein pour comprendre le mouvement apparemment inexplicable (dans le paradigme newtonien) de Mercure.

Willard Quine [4] parle aussi de ce phénomène – en allant toutefois encore plus loin dans sa critique. Il soutient la thèse du holisme de la confirmation, aussi connue sous le nom de thèse de Duhem-Quine : une proposition particulière ne fait pas face « toute seule » au tribunal de l’expérience, mais c’est l’ensemble de la théorie à laquelle elle appartient et in fine l’ensemble de notre savoir qui est testé lorsque l’on fait une expérience particulière. L’ensemble de notre savoir est un système conceptuel où il existe des connections fortes entre les différents domaines de recherche qui pourrait être pensés a priori comme indépendants. Il traduit donc autrement le fait déjà énoncé qu’il y a toujours plusieurs manières de modifier la toile d’araignée de nos connaissances pour ajuster une prédiction à l’expérience. Il énonce alors un principe de parcimonie : il est rationnel, parmi tous les ajustements possibles, de choisir en premier lieu celui qui modifie le moins de choses dans le reste de nos connaissances. Cela rejoint la métaphore de la grille de mots croisés de Susan Haack [5]. L’état d’ébriété d’un expérimentateur en neurosciences utilisant une IRM ou la fausseté de ses hypothèses seront toujours des explications plus parcimonieuses, face à une contradiction avec l’expérience, que la remise en question des lois de la mécanique quantique régissant le phénomène de résonance magnétique nucléaire sous-jacent au fonctionnement d’un dispositif d’IRM.

Irréfutabilité et méthode

Cette façon de voir les choses, pas beaucoup plus compliquée que la simple présentation du critère de réfutabilité, permet de résoudre le double problème rencontré plus haut. Les principes de bases d’une théorie sont ses règles de grammaire ; cela n’a aucun sens, ni logique, ni pratique, de penser qu’ils puissent être réfutés à l’intérieur de cette même théorie. Pour reprendre ce que dit Lakatos, cité plus haut, ce n’est pas tant une théorie qui est scientifique ou pseudoscientifique, mais plutôt la méthode avec laquelle on va la reconfigurer pour faire face à une réfutation. Plus précisément, face à une réfutation, on va modifier des hypothèses auxiliaires pour faire coller la théorie à l’expérience. La différence entre des astronomes découvrant Neptune et des platistes est alors double : 1/ face à une observation contradictoire, les astronomes « sauvent » une théorie qui est extrêmement bien corroborée par ailleurs, ce qui n’est pas le cas des platistes ; 2/ la reconfiguration de la théorie, dans le premier cas, satisfait à une exigence épistémologique contraignante de parcimonie et de prédictibilité, ce qui n’est pas le cas pour les platistes.

Comme on l’a dit, il reste indispensable, en zététique, de mettre en garde contre les propositions irréfutables en général. C’est un premier pas nécessaire, notamment pour mettre le doigt sur le fait que le propre de la science n’est pas de confirmer à tout prix ses prédictions mais d’échouer à les mettre en défaut – ce qui est impossible, ou trivial, plutôt, si l’on n’a affaire qu’à des propositions irréfutables. Pour autant, il ne semble pas non plus très coûteux de nuancer un peu ce propos, et de reconnaître que dire simplement d’une proposition isolée qu’elle est irréfutable et donc qu’elle n’est pas scientifique est un peu léger comme critique.

Lorsque la proposition en question est un principe de la théorie, sa valeur épistémique ne se juge pas par son aspect réfutable mais à l’aune de son potentiel heuristique, c’est-à-dire de sa capacité à nous faire découvrir de nouvelles entités ou des nouveaux phénomènes. Par exemple, le fait que le principe de refoulement au sein de la théorie psychanalytique soit irréfutable n’est pas un problème en soi ; le problème épistémologique de ce corpus théorique est que ses principes ne mènent à aucune prédiction validée qui aurait pu être réfutée.

S’il s’agit au contraire d’une prédiction dont la réfutation pourrait être résolue par l’ajout d’une hypothèse auxiliaire, la critique ne tient pas non plus : ce n’est pas le fait de sauver une proposition ou un noyau dur tout entier par l’ajout d’hypothèses qui est critiquable, c’est la manière avec laquelle cela est fait. Ainsi, face à toutes les observations terrestres et astronomiques que nous pouvons réaliser, on peut toujours les ajuster pour nous persuader que la Terre est plate. Cet ajustement, comme la plupart, est logiquement possible ; le problème est qu’il ne permet de faire aucune nouvelle prédiction, qu’il est hautement coûteux en hypothèses et qu’il ne tient pas face au modèle concurrent et éminemment plus parcimonieux de la Terre sphérique.

Les outils d’autodéfense intellectuelle issus de cette réflexion sont les mêmes qu’ailleurs : dans l’élaboration d’une connaissance synthétique et objective sur le monde, prédictibilité et parcimonie sont deux maîtres mots pour mener à bien cet art difficile.

Références

[1] K. Popper, La logique des découvertes scientifiques, Payot, 1973 (1934). [2] T. Kuhn, La structure des révolutions scientifiques, Flammarion, 1972 (1962). [3] I. Lakatos, A methodology of research programs, Cambridge, 1978. [4] W.V. Quine, Les deux dogmes de l’empirisme, Harper, 1953 [5] Susan Haack, Le bras long du sens commun : en guise de théorie de la méthode scientifique, Philosophiques, vol. 30 , n°2, 2003, p. 295-320. [6] W. V. Quine, On empirically equivalent Systems of the World, Erkenntnis, 3, 13–328, 1975.

Guillaume Carnino a dirigé plusieurs ouvrages collectifs (La Tyrannie technologique. Critique de la société numérique, 2006 et Les Luddites en France. Résistances à l’industrialisation et à l’informatisation, 2010), parus aux éditions L’échappée. Cette fois, il propose dans

Guillaume Carnino a dirigé plusieurs ouvrages collectifs (La Tyrannie technologique. Critique de la société numérique, 2006 et Les Luddites en France. Résistances à l’industrialisation et à l’informatisation, 2010), parus aux éditions L’échappée. Cette fois, il propose dans