Voici un très intéressant travail sur le Reiki réalisé par les étudiant-es de Licence de l’Université Grenoble-Alpes en mai 2016. Les tests se sont déroulés dans les bureaux du CorteX. Toute la rédaction est de leur fait (quand c’était nécessaire, j’ai fait des notes, en italiques, notées NdRM, notes de Richard Monvoisin). A la fin, j’ai indiqué l’extrait de notre ouvrage Tout ce… qui concerne le Reiki.

Très brièvement, qu’appelle-t-on le « Reiki » ?

Le Reiki est une technique de soin visant à soigner des zones pathologiques par « apposition des mains ». Cette dernière vient du Japon.

Elle date du début du 20eme siècle. Le Reiki se définit comme étant une « énergie universelle de vie » qui se transmettrait par les mains dans un but de guérison. Pour en devenir praticien, il suffirait de 6 à 7 jours de formations aux côtés d’un thérapeute « confirmé » (qui maîtrise cette pratique).

Il existe des écoles de Reiki, mais le Reiki ne fait l’objet d’aucunes reconnaissances légales, c’est donc une pratique non conventionnée. Chacun peut donc se déclarer « maître Reiki ».

Notre dossier ci dessous, a pour simple but de vérifier l’existence de cette « énergie universelle », et ainsi de pouvoir répondre à la question suivante : quelle est la validité scientifique du Reiki ?

Pour ce faire, nous avons choisi de tester scientifiquement cette pratique, à l’aide d’une expérience, dont voici le protocole expérimental.

Protocole expérimental : Reiki

Introduction

Dans le cadre du cours autodéfense intellectuelle de notre professeur Richard MONVOISIN (2016) (NdRM : je ne suis pas Professeur, c’est un titre universitaire bien précis que je n’ai pas), notre équipe s’est intéressée au Reiki, sa pratique mais surtout sa validité scientifique.

Alexandre GAÏD-BONNET, membre de celle-ci en est un praticien, nous allons donc avec celui-ci mettre en place un protocole expérimental visant à tester scientifiquement cette pratique.

Alexandre ressent lors de ses consultations, de la chaleur au niveau de ses mains, qui s’avère être plus ou moins intense en fonction des personnes et des zones perçues. Il ressent une « énergie » chez chacun.

Dans le cadre de sa pratique de soin, ce phénomène présente un « trou », un « creux » lorsque ses mains approchent une zone pathologique.

Élaboration du protocole

Le professionnel dit être capable de ressentir la présence de quelqu’un grâce à son énergie.

Alexandre nous affirme percevoir un signal les yeux fermés à travers les vêtements, lorsqu’il est placé à 40 cm d’un sujet en position debout.

L’équipe convient donc de le laisser choisir la personne qu’il ressent le mieux (sujet C défini plus bas).

L’énergie ressentie ne laisse pas de traces à l’endroit où se trouvait le sujet, une fois celui-ci parti.

Nous posons alors les hypothèses suivantes.

Hypothèse théorique : le professionnel est capable de déceler la présence ou l’absence d’un individu grâce à son énergie uniquement.

Hypothèse opérationnelle : le professionnel est capable de déceler la présence ou l’absence d’un individu face à lui sans aucunes conditions restrictives et derrière un paravent, muni d’un casque antibruit.

Protocole expérimental

Matériel :

– 2 casques antibruit ;

– une toile opaque ;

– du gros scotch ;

– une lampe de chevet ;

– 4 paires de bouchons d’oreilles ;

– un masque de nuit ;

– un dé.

Le nombre de passages est de 100.

Nous prenons un seuil α=0.01. (NdRM : nos jeunes collègues ont mis le calcul plus bas – ici, ils indiquent le risque de première espèce). Le nombre de réussites doit être supérieur à 65 pour être une réussite.

Variable indépendante : présence réelle vs. absence de l’individu

Variable dépendante : détection de la présence du sujet vs. absence

Alexandre est d’accord pour rendre l’expérience accessible au public.

Test en « ‘blanc »

Début avril (2016), les membres du groupe se sont réunis chez Sylvain pour se familiariser avec le protocole et le finaliser.

Premièrement Alexandre a testé chacun des membres et choisi celui dont l’énergie est la plus perceptible. Il choisit le sujet C.

S’en est suivi un tirage au sort qui détermina le rôle de chacun dans l’expérience (Alexandre étant indifférent concernant la personne qui sera à ses côtés lors de l’expérience).

Sylvain et Yoann sont quant à eux chargés de la randomisation des passages (présence vs. absence du sujet).

Individu A : le professionnel (Alexandre)

Individu B : indique quand le professionnel peut commencer sa tache et note les indications de celui-ci (absence vs. présence du sujet)

Sylvain et Yoann procèdent à la randomisation des passages à l’aide d’un dé. Ils repartissent sur deux exemplaires une série de 0 (absence du sujet) et de 1 (présence du sujet ). Le tout constituant 20 passages.

L’individu se place en face du sujet qui lui-même se trouve devant le professionnel.

Ce dernier a mis une écharpe autour de ses yeux, des bouchons d’oreilles et un casque de musique.

Sylvain et Yoann donnent un exemplaire de la randomisation à l’individu D puis s’isolent.

Ce dernier indique au sujet quand se placer devant le professionnel. Une fois le sujet en place l’individu D tape un coup sur un mur pour indiquer à l’individu B que le sujet est prêt. L’individu B place le professionnel dans l’axe du sujet, celui-ci lève son pouce s’il sent la présence du sujet et forme un zéro avec son pouce s’il n’en sent pas, puis se retire. Le professionnel dispose d’un temps illimité. L’individu B note les indications du professionnel.

L’individu D prend connaissance du signal émis par le professionnel, lance un chronomètre de 10 s, puis fait signe au sujet de se placer ou non (pouce levé : placement vs. zéro avec la main: ne se place pas).

Après les 10 s, il retape un coup sur le mur.

L’expérience est réitérée 19 fois.

Puis, on vérifie que les comptages des deux parties congruent.

Résultats du test en « blanc »

(NdRM : est appelé ici test en blanc le test de réglage, en quelque sorte la répétition générale).

(Suivi à la lettre de la procédure présente dans le protocole expérimental sur le magnétisme de l’Observatoire zététique, cf. bibliographie)

Le nombre de passages valides est de 19/20 : N=19

Le professionnel avoua avoir effleuré les cheveux du sujet lors d’un passage.

Nous calculons alors le nombre d’essais minimum réussis pour pouvoir valider l’hypothèse.

La probabilité de succès pour chaque essai est de 0.5. « La fourchette dans laquelle se trouve plus de 99% des essais sont centrées autour de M=Np (nombre de résultats attendus en moyenne) plus ou moins un intervalle I donné par la formule suivante : I=3√[N*p*(1-p)] On obtient alors : M=9.5 et I=6.54

La nouvelle fourchette est donc :

M-I<M<M+I soit 2,96<9.5≤16.04

Le résultat doit alors être supérieur ou égal à 16 pour être statistiquement recevable.

Lors du dépouillement des résultats, nous avons obtenu :

- essais valides : 19

- essais réussis : 11

- essais échoués : 8

Le résultat du test-blanc n’est pas bon : c’est un échec. (NdRM : on ne peut cependant rien en tirer en soi, puisque c’est un test en blanc, émaillé de détails rédhibitoires).

Expérience finale

Dans les locaux du CorteX, nous prenons les mêmes dispositions que lors du test blanc, et répartissons les rôles de la même manière. Cependant, nous contrôlons certaines variables supplémentaires.

Variables contrôles :

– on dépose une toile opaque au niveau de l’encadrement de la porte, le sujet et le professionnel et leurs assistants s’y placent de part et d’autre de celle-ci.

– L’individu D et le sujet sont séparés de Sylvain et Yoann qui sont dans la pièce à côté, porte fermée.

Après la randomisation, ils font passer le tirage par la fente de celle-ci a l’individu D.

– Le professionnel porte un masque de nuit (à la place de l’écharpe)

– Les individus B et D, le sujet et le professionnel portent des bouchons d’oreilles.

– L’individu B et le professionnel portent des casques antibruit par dessus.

– L’individu B indique au sujet et à l’individu D que le professionnel est prêt en levant son pouce par dessus la toile.

– Le signal qui indique que le sujet est en place est ici une lampe de chevet se trouvant dans la pièce dans laquelle sont le professionnel et son associé. Le fil de celle-ci passant sous la toile permettant à l’interrupteur de se trouver du côté de l’individu D et de son sujet.

– Les membres de l’équipe n’ont aucun moyen de communication virtuelle (téléphones, ordinateurs…)

Trois pauses sont faites à 25, 50 ; et 75 passages.

A la pause qui suivit le 50eme tirage, le professionnel et l’individu D sortirent de leur pièce, nous conduisant à une nouvelle randomisation pour les 50 derniers passages.

Résultats du test final

(Suivi à la lettre de la procédure présente dans le protocole expérimental sur le magnétisme de l’Observatoire zététique, cf. bibliographie)

Le nombre de passages valides est de 100/100 : N=100

Nous calculons alors le nombre d’essais minimum réussis pour pouvoir valider l’hypothèse.

La probabilité de succès pour chaque essai est de 0.5.

« La fourchette dans laquelle se trouve plus de 99% des essais sont centrées autour de M=Np (nombre de résultats attendus en moyenne) plus ou moins un intervalle I donné par la formule suivante : I=3√[N*p*(1-p)] »

On obtient alors : M=50 et I=15

La nouvelle fourchette est donc :

M-I<M<M+I soit : 35<50≤65

Le résultat doit alors être supérieur ou égal à 65 pour être statistiquement recevable.

Après dépouillement nous avons :

- essais valides : 100 ;

- essais réussis : 51 ;

- essais échoués : 49.

Le résultat de l’expérience conclue à un échec.

Conclusion

Au terme de cette expérience, le résultat est décevant.

Nous sommes de tout cœur avec Alexandre pour qui l’expérience se solde d’une double déception : en plus de l’échec de l’expérience il doit faire face au fait que ses soins ne présentent pas plus d’effet qu’un placebo (NdRM : ce point est inexact : les étudiant-es n’ont montré que le fait que le sujet ne pouvait distinguer par Reiki la présence ou l’absence de l’émetteur, pas que ses soins étaient placebo. En outre, contrairement à ce que nous avons bien étudié en cours, l’effet placebo est une notion complexe qu’il vaut mieux subdiviser en différents effets contextuels). Il fait cependant preuve d’un grand fair-play.

Avant l’expérience il nous affirmait qu’il saurait accepter le résultat quel qu’il soit, et ce fut le cas. Nous admirons tous son attitude.

Limites de l’expérience

- Il n’a pas été possible pour nous d’expérimenter le Reiki sur des patients faute de moyens et de temps. Nous incitons donc vivement d’autres chercheurs à le faire.

- Bien que l’expérience ait été effectuée en suivant un rigoureux protocole expérimental, elle n’a été faite qu’une fois. Peut-être avons nous omis certaines variables/détails/biais expérimentaux. Nous incitons donc d’autres chercheurs à la reproduire avec de nouveaux locaux, de nouveaux sujets, professionnels.. et même dans d’autres contextes socioculturels.

- Nous avons tenté de contacter mercredi 4 mai 2016 un professionnel du domaine, le chercheur et kinésithérapeute Nicolas PINSAULT, afin de prendre connaissance de son point de vue sur cette pratique. Ce dernier, sûrement très pris par son travail, (NdRM : il faut dire que vous l’avez contacté à la dernière minute !) nous a affirmé « avoir trop peu travaillé la question pour nous donner un avis éclairé ». Nous le remercions tout de même d’avoir pris le temps de nous répondre.

Bibliographie (NdRM : assez maigrelette, il faut le dire – mais devant un si joli protocole, on ne leur en tiendra pas rigueur) :

- Protocole magnétisme, Observatoire zététique, 2004.

- Qui sommes-nous ? Fédération de Reiki

- Site Le Reiki

DO Thi-My-Phuong : L1 biologie

SASSE Sylvain : L1 Science de la Vie et de la Terre

BOUAÏCHA Sonia : L2 psychologie

BOUCARD Yoann : L1 biologie

BOUVIER Marie : L1 biologie

GAÏD-BONNET Alexandre : L1 chimie-biologie

Extrait de Pinsault N., Monvoisin R., « Tout ce que vous n’avez jamais voulu savoir sur les thérapies manuelles« , Presses Universitaires de Grenoble,pp. 98-99

Reiki (1922)

[Fondateur] Mikao Usui (Japon) (1865-1926), moine bouddhiste.

L’histoire du fondateur est fortement controversée. Il est dit que, fréquentant un temple bouddhiste Tendaï (tradition du Grand Véhicule) au nord de Kyõto, Mikao Usui étudia d’abord le Kiko, version japonaise du Qi Gong (« exercice de Qi », en mandarin), gymnastique traditionnelle chinoise proposant une méthode de respiration fondée sur la maîtrise du Qi, l’énergie vitale alléguée. Sous l’influence d’un « maître », Watanabe Kioshi Itami, il aurait changé d’école bouddhiste en 1894, passant de Tendaï à Shingon (un des bouddhismes tantriques, la grande différence tenant dans la possibilité d’atteindre l’état du bouddha dans cette vie-ci, et non dans une autre).

On a prêté à Usui des études de psychologie (ce qui est peu probable pour l’époque), de médecine (ce que nous n’avons pu vérifier) et un doctorat en théologie de l’université de Chicago, mais l’unique source, The Reiki handbook (Arnold & Nevius, 1992), est pour le moins douteuse (son coauteur étant Larry E. Arnold, bien connu entre autres pour avoir développé des thèses paranormales fantaisistes sur les auto-combustions humaines « spontanées »).

Après vérification, comme l’indique le site ihReiki.com dans son article Historical Reiki inconsistencies, personne de ce nom n’étudia à ladite université dans cette période. Bref, Usui, en proie à des difficultés financières, aurait décidé d’embrasser la carrière monastique et c’est en 1922 qu’il fit une expérience de mort imminente (« visions » ou « sensations » consécutives à une mort clinique ou à un coma avancé), ainsi qu’un satori (une illumination) pendant une retraite jeûnée sur le Mont Kuruma-yama. Il y « reçut » le Reiki. Il ouvrit alors un, puis deux centres, et créa son enseignement.

Mais cette histoire est douteuse et remaniée plusieurs fois. Des héritiers spirituels, en particulier la maître Reiki Hawayo Takata (1900-1980), créèrent de toutes pièces des détails, comme une prétendue inspiration de Usui par le personnage de Jésus, afin de

mieux exporter la méthode en « Occident ». Pire encore, des faux documents prêtés à Usui lui-même étaient en fait l’œuvre d’un faussaire, par ailleurs faux psychologue et faux enseignant de Reiki, le Lama Yeshé, qui s’avéra être… un faux Lama, Richard Blackwell.

Les fraudes et inventions de Blackwell ont dupé et dupent encore un certain nombre de praticiens Reiki, ce qui lui a valu les foudres d’une grande part de la communauté. Blackwell rebondit et fit une résolution de dissonance cognitive spectaculaire en se déclarant en ‘‘channeling’’ avec Usui lui-même. Puis il affirma être poursuivi par la CIA, avant de disparaître vers la fin des années 2000.

Mode de découverte : une épiphanie.

Scientificité de la découverte : aucune publication scientifique publiée du fondateur.

Principe théorique non étayé : l’imposition des mains apporterait des soins dits « énergétiques ».

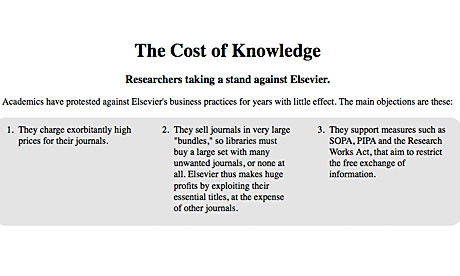

Leur vase déborda lorsqu’en décembre 2011 fut présenté au Congrès états-unien un projet de

Leur vase déborda lorsqu’en décembre 2011 fut présenté au Congrès états-unien un projet de  Curie a relayé le boycott, elle qui dépense 1,02 millions d’euros pour ces abonnements. Puis l’Université de Harvard a suivi car bien qu’elle soit la deuxième institution à but non lucratif la plus riche dans le monde, ses comptes sont gravement amputés par les abonnements aux revues académiques : il semble que le prix des abonnements lui coûte chaque année en moyenne 3,75 millions de dollars. Le directeur de la bibliothèque, Robert Darnton, a déclaré dans le Guardian :

Curie a relayé le boycott, elle qui dépense 1,02 millions d’euros pour ces abonnements. Puis l’Université de Harvard a suivi car bien qu’elle soit la deuxième institution à but non lucratif la plus riche dans le monde, ses comptes sont gravement amputés par les abonnements aux revues académiques : il semble que le prix des abonnements lui coûte chaque année en moyenne 3,75 millions de dollars. Le directeur de la bibliothèque, Robert Darnton, a déclaré dans le Guardian :

= dx/dt, l’« accélération » γ = d²x/dt², la « force » F = mγ sont des concepts analytiques quantitatifs parce qu’ils résultent de la combinaison de grandeurs élémentaires mesurables (dans le cas de la vitesse : une certaine quantité d’espace dx et une certaine quantité de temps dt). Au contraire, les « concepts qualitatifs » ne supposent aucune mesure. C’est le cas des concepts de la topologie, comme ceux de « boule » ou d’« anneau de Möbius » (voir ci-contre, l’anneau de Möbius par le graveur Escher).

= dx/dt, l’« accélération » γ = d²x/dt², la « force » F = mγ sont des concepts analytiques quantitatifs parce qu’ils résultent de la combinaison de grandeurs élémentaires mesurables (dans le cas de la vitesse : une certaine quantité d’espace dx et une certaine quantité de temps dt). Au contraire, les « concepts qualitatifs » ne supposent aucune mesure. C’est le cas des concepts de la topologie, comme ceux de « boule » ou d’« anneau de Möbius » (voir ci-contre, l’anneau de Möbius par le graveur Escher).