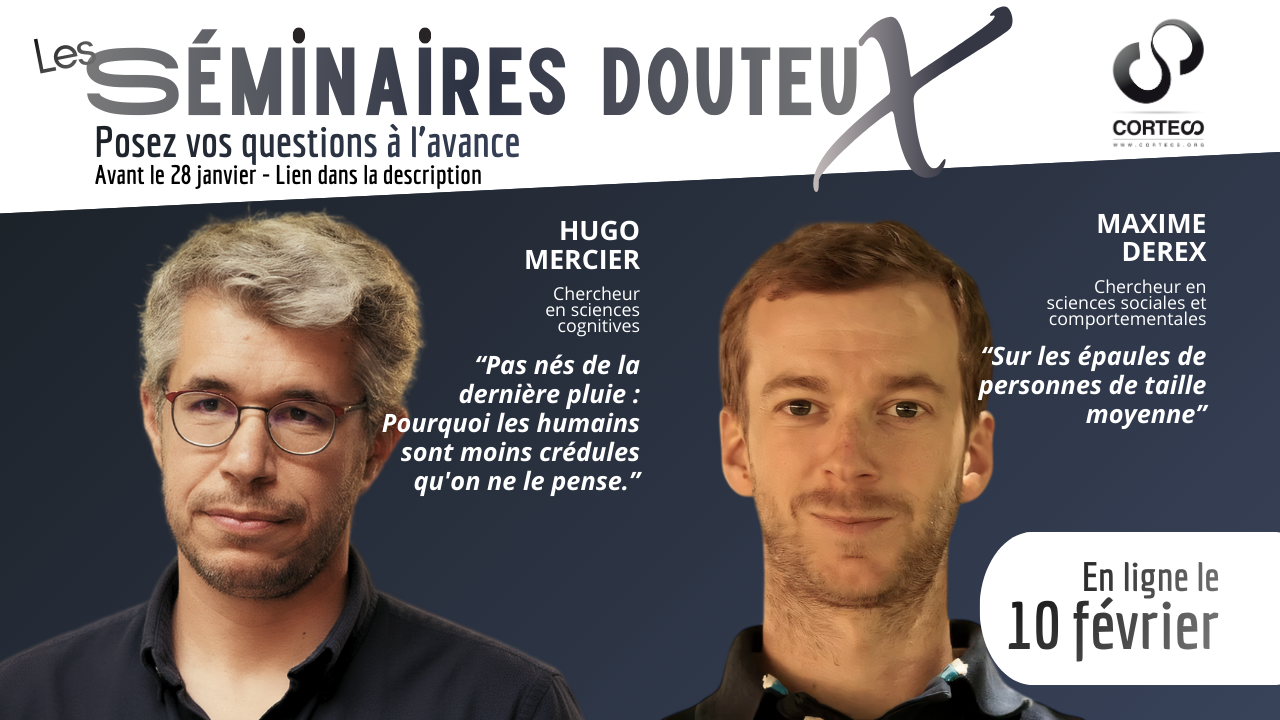

Voilà le deuxième séminaire douteux qui arrive ! Après « Peut-on enseigner l’esprit critique ? » avec Charlotte Barbier et Denis Caroti, nous acceuillons ce mois-ci les chercheurs Hugo Mercir et Maxime Derex autour de la thématique « Sommes-nous (si) idiots ? » qui remettent en cause les conceptions naïve concernant notre prétendue irrationalité et proposent des visions alternatives.

Il sera enregistré début Février (toujours pas de solutions satisfaisantes pour organiser un live) et mis en ligne le 10 Février.

Rediffusion

C’est quand ? C’est où ?

Les séminaires douteux c’est en ligne. Cette deuxième édition sera enregistrée le 3 Février et, malheureusement, elle ne sera pas diffusé en live mais vous pouvez retrouver l’enregistrement quelques jours plus tard. On réfléchit fort pour trouver une solution pour que les séminaires puissent être suivi en direct.

Poser vos questions

Nous mettons à disposition un document collaboratif que nous transmettrons aux intervenants pour qu’ils puissent s’en inspirer pour préparer leur intervention. Posez vos questions ici.

Interventions

Maxime Derex – Sur les épaules de personnes de taille moyenne

Les problèmes complexes sont souvent résolus par un raisonnement collectif, au cours duquel des solutions sont progressivement améliorées au fil du temps. Dans certaines conditions, ce processus peut même produire des solutions qui dépassent la compréhension des individus qui composent le groupe. Dans cette présentation, je montrerai comment certaines caractéristiques des groupes influencent notre capacité à résoudre collectivement des problèmes qui nous dépassent. J’illustrerai aussi une tension centrale de ce processus: comment préserver et transmettre ce qui a été construit avant nous, alors même que ces solutions dépassent notre compréhension individuelle.

Maxime Derex est chercheur au Département de sciences sociales et comportementales de la Toulouse School of Economics. Il étudie l’évolution culturelle, et en particulier la culture cumulative, le processus par lequel les innovations s’accumulent à travers les générations.

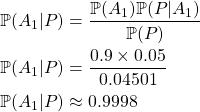

Hugo Mercier – Pas nés de la dernière pluie : Pourquoi les humains sont moins crédules qu’on ne le pense

On pense souvent que les humains sont crédules, facilement manipulés par démagogues, publicitaires, et politiciens. Je défendrai ici l’argument contraire : les humains sont équipés d’un ensemble de mécanismes psychologiques leur permettant de bien évaluer les informations communiquées, et de rejeter celles qui sont fausses ou nuisibles. Je m’appuierai sur des données de psychologie expérimentale, ainsi que des études montrant les échecs de la persuasion de masse, de la propagande Nazi aux campagnes présidentielles américaines. Finalement, je suggérerai des explications au succès de certaines idées fausses—des théories du complot à la résistance aux vaccins—qui ne reposent pas sur la crédulité.

Hugo Mercier est un spécialiste de sciences cognitives, travaillant à l’Institut Jean Nicod à Paris. Il étudie le raisonnement humain et la communication, ainsi que l’évolution culturelle. Il est le co-auteur, avec Dan Sperber, de The Enigma of Reason, et l’auteur de Not Born Yesterday: The Science of Who we Trust and What we Believe.

C’est quoi les séminaires douteux ?

Bonne question ça ! On vous renvoie vers la page Les séminaires douteux sur laquelle vous trouverez toutes les infos : le projet, les séminaires à venir, les séminaires passés…