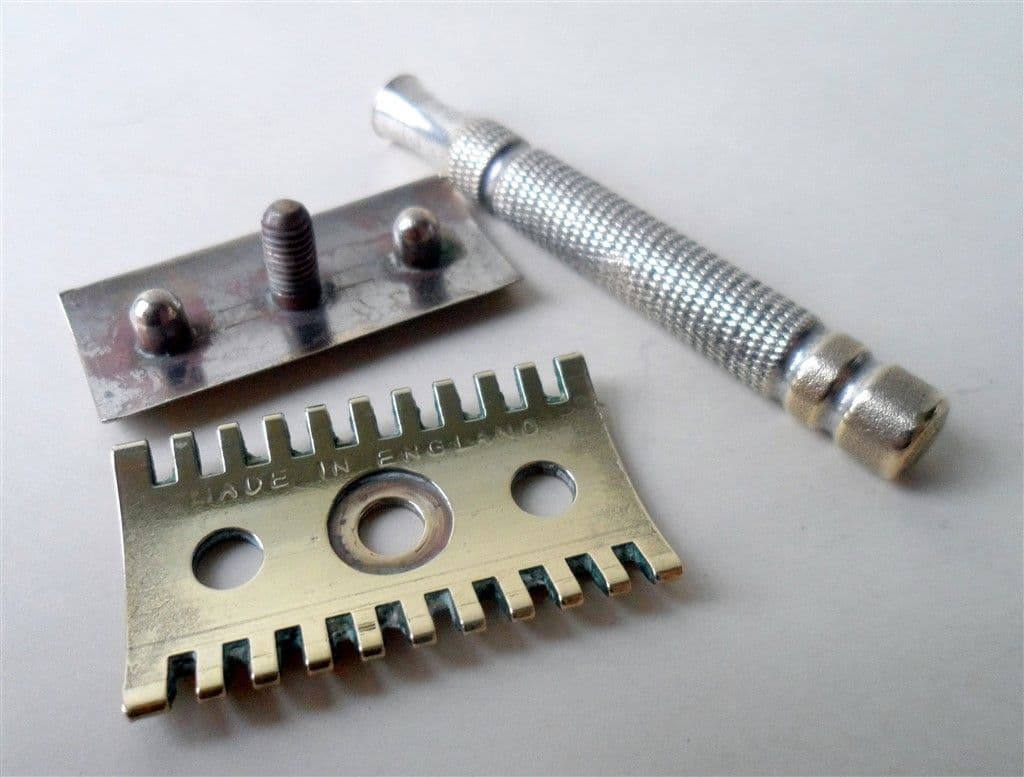

Le rasoir d’Ockham ! Quel outil intellectuel puissant. Ce principe (également appelé principe de parcimonie) nous dit qu’il faut privilégier la théorie avec les hypothèse les plus parcimonieuses. Autrement dit, les hypothèses les plus vraisemblables, les moins coûteuses ou les moins farfelues (nous nous attarderons pas ici sur la signification exacte, vous pouvez aller voir ici). C‘est un outil érigé comme pilier central de la pensée critique qui est enseigné et éculé depuis des siècles bien avant Guillaume d’Ockham d’ailleurs (Une liste des différentes formulations de ce principe à travers l’histoire est disponible sur le site Toupie.org : Les différentes formulations du rasoir d’Ockham). Mais quelle est la portée réelle de ce principe ? Qu’est-ce qu’il nous permet vraiment de dire sur le monde ? Nous allons le voir, le rasoir d’Ockham bien souvent est employé bien au-delà de son domaine d’application. Loin d’être anecdotique, ce mésusage du rasoir d’Ockham est probablement symptomatique d’une certaine manière de faire de l’esprit critique. Nous partirons donc d’une critique spécifique à cet outil pour questionner d’un point de vue philosophique plus globalement notre rapport à la pensée critique (oui, rien que ça !)

Si vous préférez, cet article est également disponible en vidéo ici.

Préliminaire : là ou le rasoir d’Ockham se grippe.

Quel est le problème ?

Commençons par donner deux exemples sur les limites du rasoir d’Ockham.

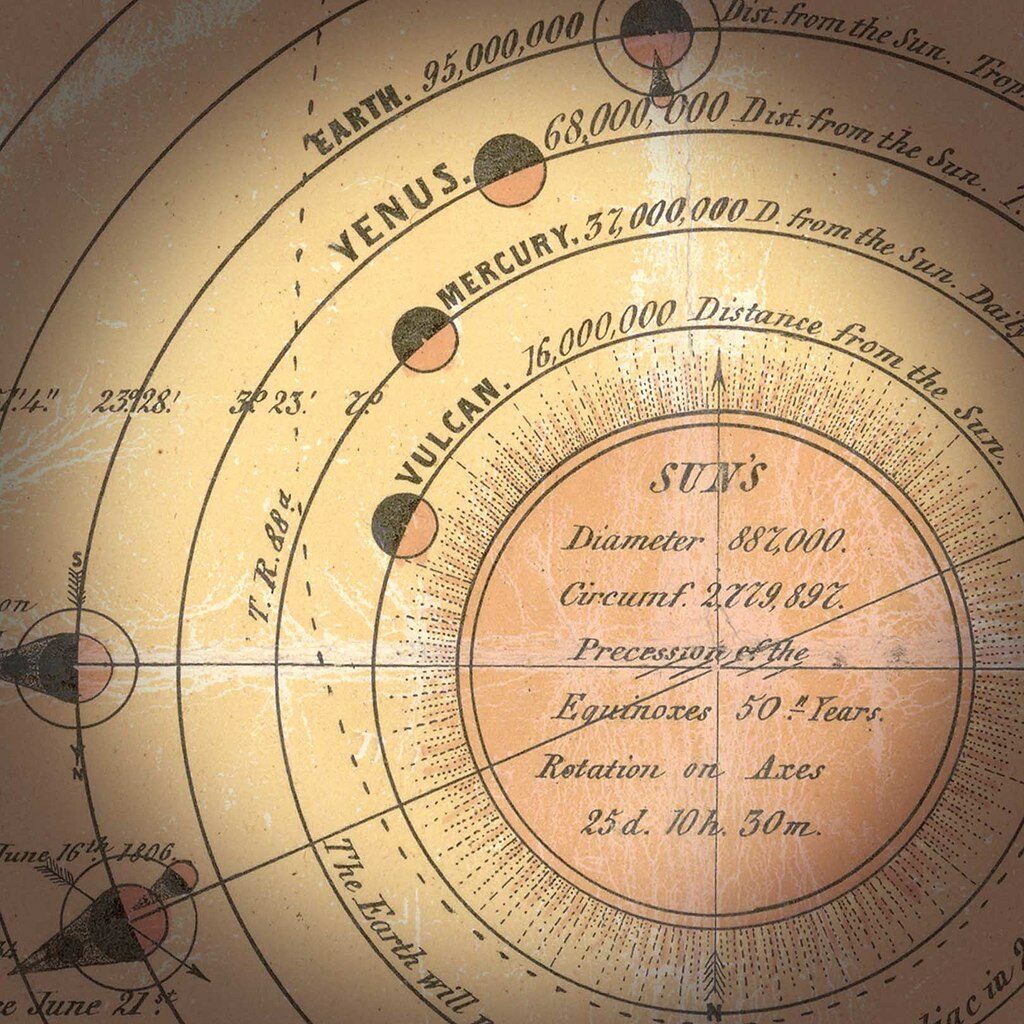

Une équipe de la NASA collecte des données qui indiquent la présence d’un objet astronomique qui n’était pas encore référencé. D’après les études préliminaires, il y a de grandes chances pour que ce soit une petite comète qui passera à quelques centaines de millions de kilomètres de la Terre. Cependant, les mêmes données sont également compatibles avec une comète qui s’écraserait sur Terre dans les prochains mois. Mais ce genre de comète est assez rare et il faudrait qu’elle aie été captée avec un angle très particulier pour correspondre aux données. L’équipe estime pour l’heure à 0,004 % (1 chance sur 25000) la probabilité que ce soit effectivement une comète qui vise la terre.

Est-ce qu’il faut donc privilégier l’hypothèse de la comète inoffensive ? Et dans quelle mesure ? Quid si la probabilité était de 0,000004 % ou 0,4 % ?

Prenons un autre exemple : l’autre jour j’étais en forêt et je trouve un champignon (c’est faux je ne trouve jamais de champignon, c’est pour l’exemple). Piètre mycologue que je suis, j’ai du mal à identifier de quel champignon il s’agit. Il me semble cependant reconnaître un cèpe et je me rappelle qu’un ami m’a dit il y a quelques jours que dans ce coin-là presque tous les champignons sont comestibles, d’autant plus si ils n’ont pas de collerette. Tout porte à croire alors que mon champignon est comestible (pour rendre l’exemple plus parlant, vous pouvez d’ailleurs imaginer d’autres indices rendant plus crédible la comestibilité du champignon). Considérant les deux théories T1 : « le champignon est comestible » et T2 : « le champignon n’est pas comestible », les indices que j’ai en ma possession me poussent donc à croire que la théorie T1 est plus parcimonieuse.

Est-ce que je dois pour autant manger ce champignon ? Autrement formulé, qu’implique exactement le privilège accordé à cette théorie ? Quelle est sa portée ?

Ces deux exemples ont pour but de montrer qu’on ne peut pas se contenter de dire qu’il faut privilégier les hypothèses les plus parcimonieuses sans plus de précision

➤ Complément : Est-ce que ces exemples parlent réellement du rasoir d’Ockham ? (cliquer pour déroulé)

C’est un des retours critique que j’ai reçu à la sortie de cet article, je rajoute donc cette petite note pour ajouter des précisions. En réalité cela dépend ce que l’on entend par « parcimonie » dans principe de parcimonie. Dans une acception classique, la parcimonie correspond au faible nombre d’entités explicatives. Ainsi on préfèrera une explication qui ne fait pas intervenir d’extra-terrestre, de cryptide ou de pouvoir parapsychique si l’on peut s’en passer. De ce point de vue-là, les exemples donnés tape à coté : les théories concurrentes (champignon comestible vs. non comestible dans un cas, météorite dangereuse vs. inoffensives dans l’autre) ont chacune le même nombre d’entité explicative. Il est donc faux de dire que le rasoir d’Ockham dit quelque chose ici de la théorie à privilégier.

On peut cependant considérer une version un peu différente de cette parcimonie en considérant la plausibilité des hypothèses. Cette acception quoique abusive par rapport au sens original du rasoir d’Ockham semble etre toutefois utilisé (c’est celle-ci d’ailleurs qui est présentée et démontrée dans notre article Vers une vision bayésienne de la zététique).

La portée réelle du rasoir d’Ockham

Alors, le rasoir d’Ockham est il faux ? Faut-il l’abandonner dans nos réflexions et nos enseignements ? Non, ce n’est pas nécessaire. En fait il faut plutôt faire attention à ce qu’on lui fait dire. Considérons deux manières différentes de formuler le rasoir d’Ockham :

- La théorie la plus vraisemblable est celle ayant les hypothèses les plus parcimonieuses.

- Il faut privilégier la théorie ayant les hypothèses les plus parcimonieuses.

Ces deux formulations semblent relativement proches mais en réalité elles ne disent pas la même chose. D’une certaine manière la première formulation est une version faible du rasoir d’Ockham alors que la seconde va plus loin en donnant une valeur prescriptive au rasoir d’Ockham ce qui est, on va le voir, difficilement justifiable. C’est cette seconde formulation du rasoir d’Ockham que nous allons tenter de creuser ici. Et cette formulation du rasoir d’Ockham est relativement commune1. Et moi même, je l’utilise telle quelle la plupart du temps. Par abus de langage et suivant le contexte, ça peut tout à fait être entendable, mais il est intéressant d’investiguer en toute rigueur ce qui ne va pas avec cette formulation et en quoi cela nous renseigne plus généralement sur notre manière de conceptualiser la rationalité et la pensée critique. Détaillons donc la construction de cette formulation prescriptive du principe de parcimonie.

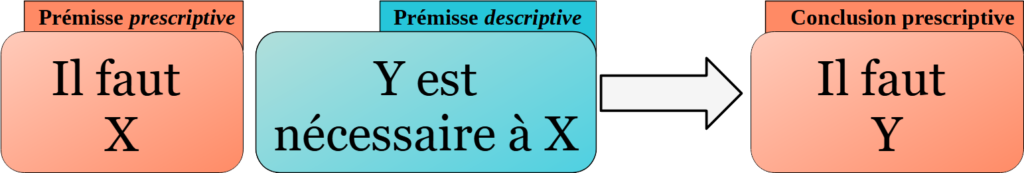

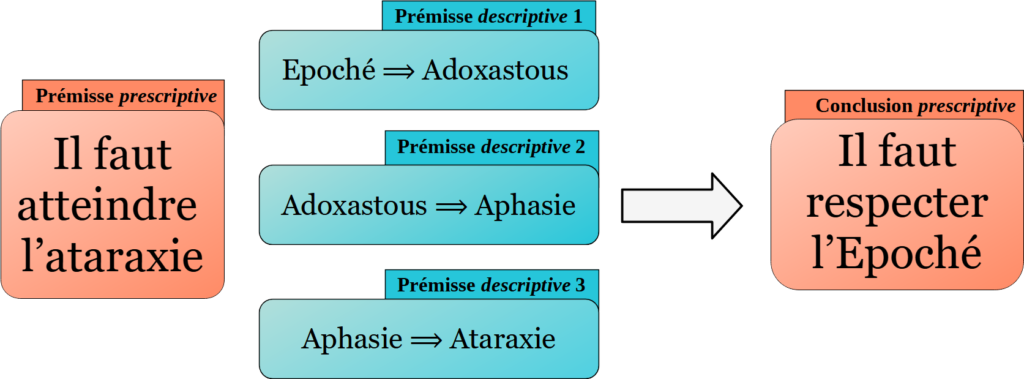

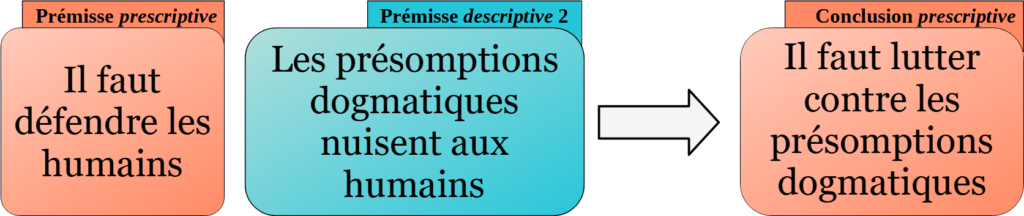

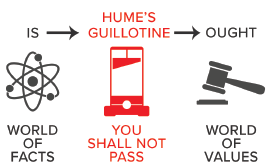

Passer de la première formulation à la seconde sans plus de justification est une erreur de logique : une prescription ne peut se déduire simplement d’une description. C’est un principe fondamentale de logique que l’on appelle la guillotine de Hume. Une autre formulation, que l’on doit à Raymond Boudon2, dit qu’on ne peut passer d’une prémisse à l’indicatif (la première formulation) à une conclusion à l’impératif (la seconde formulation)

Pour avoir une construction logique qui aboutisse à la seconde formulation, il faudrait en réalité deux prémisses :

- La théorie la plus vraisemblable est celle ayant les hypothèses les plus parcimonieuses.

- Il faut privilégier la théorie la plus vraisemblable.

On peut appeler la première prémisse « rasoir d’Ockham descriptif » et la deuxième « injonction au vraisemblable ». De ces deux prémisses ont peut alors conclure aisément « Il faut privilégier la théorie ayant les hypothèses les plus parcimonieuses » que l’on pourra appeler « rasoir d’Ockham prescriptif ». Mais c’est là que le bât blesse, la seconde prémisse n’est pas gratuite du tout et ne peut pas être mobilisée à la légère. Les deux exemples d’introduction devraient vous en convaincre.

Une autre formulation du rasoir d’Ockham consiste à dire « il ne faut pas accumuler les hypothèses superflues » 3. Encore une fois, cette formulation ne poserait pas de problème si on précise que ce « il ne faut pas » se cantonne au cas où l’on recherche la théorie la plus vraisemblable. Mais, comme nous l’avons vu, un « il ne faut pas » absolu ne tient pas. Ceci étant dit cette autre formulation est intéressante parce qu’elle permet de voir le problème sous un nouvel angle : il existe de nombreux cas où il est en réalité rentable d’ajouter des hypothèses superflues. L’hypothèse du champignon toxique ou celle de la météorite qui pourrait nous écraser aussi peu parcimonieuses soient-elles peuvent être salvatrices pour nous, il est donc rentable de les tenir pour vraies.

La manière dont nous mobilisions communément le rasoir d’Ockham nous a donc permis de mettre en lumière une hypothèse sous-jacente, relativement insidieuse et largement répandue : une injonction au vraisemblable : « La théorie la plus vraisemblance doit être retenue ! ».

Laissons de coté ce cher Ockham pour nous concentrer plus généralement sur l’utilisation de cette hypothèse et sur sa légitimité.

« Tu privilégieras la meilleure hypothèse »

Suivant les contextes, la prémisse d’injonction au vraisemblable est parfois pertinente et parfois elle ne l’est pas. Prenons deux exemples classiques des enseignements de pensée critique :

- On enferme un chat et une souris dans une pièce. Dix minutes plus tard on y retrouve plus que le chat. On peut alors formuler plusieurs théories : « le chat a mangé la souris », « la souris s’est téléportée », « la souris a tué le chat et a pris son apparence », etc. Cet exemple classique que l’on doit à Stanislas Antczak est souvent utilisé en cours pour illustrer le principe du rasoir d’Ockham.

Ici il est clair que quand on dit qu’il faut privilégier la théorie ayant les hypothèses les plus parcimonieuses, il est sous-entendu que c’est dans un cadre spécifique où l’on cherche à trouver l’explication la plus vraisemblable dans un exemple théorique. La prémisse d’injonction au vraisemblable peut donc être sous-entendue sans problème. - Une femme Cro-Magnon se promenant en foret entend un bruit dans un buisson. Les prédateurs étant rares à cet endroit il est probable que ce soit seulement le vent ou une petite bête inoffensive. La théorie la plus parcimonieuse est donc « ce n’est pas un prédateur ». Faut-il pour autant la privilégier c’est-à-dire la tenir pour vrai4 et agir en fonction ? Non, ce serait trop risqué, s’il s’agit effectivement d’un prédateur elle pourrait se faire attaquer. Accepter l’injonction à la vraisemblance ici serait une erreur de raisonnement en plus d’être une vraie menace pour la survie. La théorie à privilégier est plutôt celle de la présence d’un prédateur c’est à dire la théorie qui a le plus de chance de sauver les fesses de notre aventurière.

On peut alors marquer une différence essentielle entre la théorie la plus vraisemblable et la théorie la plus rationnelle à adopter. Ainsi, il existe des situations où le choix rationnel n’est pas d’adopter la théorie la plus vraisemblable. On pourrait même conjecturer que c’est le cas dans la plupart des situations.

Faisons un petit jeu en guise de dernier exemple. Nous faisons un pari sur la réalité d’une visite extraterrestre. Voici les enjeux :

- Si aucun extra-terrestre n’a visité la terre au cours du siècle dernier, tu gagnes : je t’offre une chocolatine.

- Si, au contraire, au moins un extra-terrestre a visité la terre au cours du siècle dernier, je gagne : tu dois boire un poison mortel.

Alors acceptez-vous mon pari ?

Un petit modèle mathématique

Cette section propose d’illustrer la situation au travers d’un modèle mathématique. Si vous n’êtes pas très à l’aise, vous pouvez passer directement à la section suivante.

Une manière d’envisager le problème est de considérer deux éléments :

- La vraisemblance de la théorie

- Les enjeux associés à l’adoption de cette théorie.

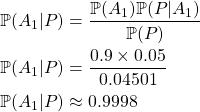

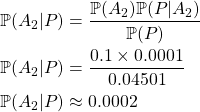

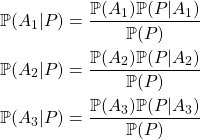

Il semble alors que la théorie qu’il faut tenir pour vraie doit prendre en compte la vraisemblance des différentes théories pondérées d’une certaine manière par les enjeux associés à chacune de ces théories. Essayons de mathématiser cela : Imaginons une situation dans laquelle s’affrontent deux théories T1 et T2 5 et on note P(Ti) la probabilité (ou la vraisemblance) de la théorie Ti.. On note enfin T* la théorie qu’il faut privilégier, c’est-à-dire la théorie qu’il faut tenir pour vraie. La formulation du rasoir d’Ockham prescriptif « Il faut privilégier la théorie ayant les hypothèses les plus parcimonieuses » L’injonction à la vraisemblance pourrait alors se traduire comme suit :

La théorie T* est telle que P(T*) ≥ P(Ti),

Autrement dit, la théorie à privilégier est celle parmi les deux théories qui a la plus grande probabilité d’être vraie.

Maintenant introduisons une fonction d’utilité u, qui à chaque paire de théorie Ti et Tj associe un nombre u(Ti | Tj) (entre -1 et 1 par exemple) correspondant à la balance bénéfice/coût liée au fait de tenir pour vraie la théorie Ti alors que c’est la théorie Tj qui est vraie. Donc par exemple u(T1 | T2) correspond à l’utilité de tenir T1 pour vrai alors que c’est T2 qui est vraie et u(T1 | T1) correspond à l’utilité de tenir T1 pour vrai alors que c’est bien que T1 qui est vraie. On pourrait alors choisir la théorie T* à privilégier comme ceci :

La théorie T* est telle que

u(T*,T1)×P(T1) + u(T*,T2)×P(T2) ≥ u(Ti,T1)×P(T1) + u(Ti,T2)×P(T2)

Autrement dit, la théorie à privilégier est celle parmi les deux théories dont l’adoption a les plus grands bénéfices attendus. Pour faire un parallèle avec le rasoir d’Ockham, on pourrait appeler ce principe le rasoir de Darwin puisque c’est celui qui maximise les conséquences positives et donc les chances de nous sauver les fesses (le rasoir « Gillette de sauvetage » marche aussi).

On peut ici reconnaître une vieille idée : celle du pari de Pascal. Il vaut mieux croire en Dieu puisque les gains sont infiniment plus grands s’il existe que le sont les pertes s’il n’existe pas. Au moment de faire un choix il ne faut pas seulement considérer la vraisemblance de l’existence ou de la non-existence de Dieu, il faut également considérer les enjeux liés à chacune de ses possibilités.

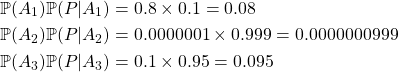

Afin d’illustrer cette mathématisation qui peut paraître obscure, reprenons l’exemple évoqué ci-dessus de la femme Cro-Magnon. On considère trois théories :

- T1 : « Il s’agit d’un prédateur »

- T2 : « Il s’agit d’une bête inoffensive »

- T3 : « Il s’agit d’un coup de vent »

Les probabilités associées sont par exemple P(T1 ) = 0,05 ; P(T2 ) = 0,35 ; P(T3 ) = 0,6.

L’injonction à la vraisemblance impliquerait donc de privilégier la théorie T3 : « Il s’agit d’un coup de vent ». Mais, nous l’avons vu, c’est un choix risqué. La théorie T3 n’est donc pas celle à privilégier est elle seulement la plus vraisemblable.

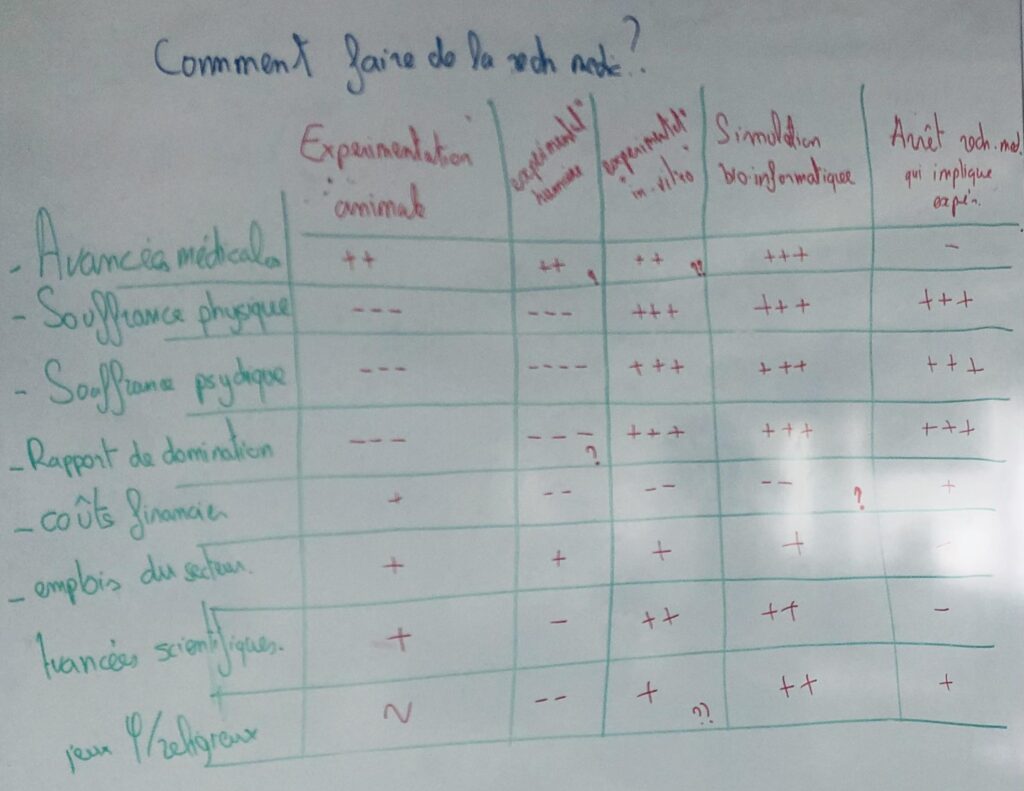

Considérons ensuite les fonctions d’utilité u(Ti, Tj) 6 résumée dans le tableau suivant :

| Ti (je tiens pour vrai) ↓ \ Tj (réalité) → | T1 : prédateur | T2 : bête inoffensive | T3 : coup de vent |

| T1 : prédateur | 1 Vrai positif : Je considère que c’est un prédateur et c’est réellement un prédateur → Course et survie | -0,02 Faux positif : Je considère que c’est un prédateur et c’est une bête inoffensive → Course pour rien | -0,02 Faux positif : Je considère que c’est un prédateur et c’est un coup de vent → Course pour rien |

| T2 : bête inoffensive | -1 Faux négatif : Je considère que c’est une bête inoffensive et c’est un prédateur → Pas de réaction, mort | 0 Vrai positif : Je considère que c’est une bête inoffensive et c’est réellement une bête positive → Pas de réaction | 0 Faux négatif : Je considère que c’est une bête inoffensive et c’est un un coup de vent → Pas de réaction et erreur sans conséquence |

| T3 : coup de vent | -1 Faux négatif : Je considère que c’est un coup de vent et c’est un prédateur → Pas de réaction, mort | 0 Faux négatif : Je considère que c’est un coup de vent et et c’est une bête inoffensive → Pas de réaction et erreur sans conséquence | 0 Je considère que c’est un coup de vent et c’est réellement un coup de vent → Pas de réaction |

On peut alors calculer pour chaque théorie Ti la somme pondérée des utilités pour savoir laquelle il vaut mieux privilégier :

- u(T1,T1)×P(T1) + u(T1,T2)×P(T2) + u(T1,T3)×P(T3) = 1× 0,05 – 0,02 × 0,35 – 0,02 v 0,6 = 0,031

- u(T2,T1)×P(T1) + u(T2,T2)×P(T2) + u(T2,T3)×P(T3) = -1× 0,05 + 0 × 0,35 + 0 × 0,6 = -0,05

- u(T3,T1)×P(T1) + u(T3,T2)×P(T2) + u(T3,T3)×P(T3) = -1× 0,05 + 0 × 0,35 – 0,2 × 0,6 = -0,05

Ainsi, il convient de tenir pour vrai la théorie T1. Ce qui est en effet le choix le plus rationnel.

D’une certaine manière la formulation du rasoir d’Ockham prescriptive (« Il faut privilégier la théorie ayant les hypothèses les plus parcimonieuses ») est un cas particulier de ce rasoir de Darwin dans lequel on considérerais que toutes les fonctions d’utilité sont égales. Et c’est tout à fait pertinent dans de nombreux cas, notamment quand on est le cul posé en amphi et que l’on cherche la bonne explication pour la disparition d’une souris imaginaire. Mais ça ne l’est plus quand on considère des choix concrets qui ont des impacts matériels dans nos vies.

Oui mais enfin, me dira-t-on, tu chipotes avec tes formules mathématiques et tes nuances sémantiques, personne ne fait cet abus-là ! Et bien, au contraire, il me semble que cela a des effets concrets sur la manière dont on parle et dont on transmet la pensée critique. L’idée (fallacieuse nous l’avons vu) qu’il serait toujours logique de privilégier le plus vraisemblable est, il me semble, un postulat sous-jacent et invisible qui semble assez largement répandu. Nous allons essayer de voir cela dans la partie suivante.

Quelques considérations sur la manière de transmettre la pensée critique

Parler du rasoir d’Ockham était surtout un prétexte. Ce principe reste bien évidement très utile dans de nombreux cas et notamment quand il s’agit de réfuter l’existence d’entité explicative superflue (extra-terrestre, cryptides, phénomènes psy, théières cosmique, licornes invisible et autres dragons dans le garage). Mais son application à des cas concrets est plus délicate et met en exergue une erreur logique que l’on a tendance à faire : considérer que le plus vraisemblable est nécessairement le plus rationnel à adopter. Et c’était plutôt cette idée que l’on voulait souligner ici.

Lutter contre cette idée c’est aussi aller vers une pensée critique plus large en cela qu’elle prend en compte au delà des considérations épistémologique, les conditions concrètes des individus, les enjeux et les intérêts particuliers qui peuvent gouverner a l’adoption d’une position. Cet aspect peut se retrouver dans certaines définition de l’esprit critique comme chez Matthew Lipman qui parle de sensibilité au contexte8 :

La pensée critique est cette pensée adroite et responsable qui facilite le bon jugement parce qu’elle s’appuie sur des critères ; elle est auto-rectificatrice ; elle est sensible au contexte.

Matthew Lipman (1988), « Critical thinking: What can it be? »

Je ne sais pas tout à fait ce qu’entendait Lipman par « sensibilité au contexte », mais il nous semble pertinent d’y voir une sensibilité aux enjeux. L’occasion de souligner que cette conception de l’esprit critique centrée sur la plausibilité n’est pas universelle. La recherche en esprit critique ou les théories du choix rationnel dépassent clairement cette conception là. Mais il semblerait qu’elle soit assez répandue dans une approche classique de la zététique (ce qui n’est pas sans rappeler la très bonne conférence Les deux familles du scepticisme de l’ami Tranxen)

Comprendre des choix jugés irrationnels

Il est d’autant plus intéressant de considérer ce double aspect – vraisemblance et enjeux – que c’est probablement quelque chose de cette forme-là qui a été sélectionné au fil de l’évolution et qui est effectivement implanté dans nos schémas de prise de décision9. Nous prenons des décisions en combinant ce qui nous semble vraisemblable (but épistémiques) et ce qui nous semble nous bénéficier (but non-épistémiques) 10. Prenons l’exemple d’une personne qui croit en une thèse conspirationniste. Ce n’est pas forcément que la personne croit plus vraisemblable que nous soyons dirigés par des lézards extraterrestres, mais c’est peut-être qu’elle considère plus utile, plus rentable pour elle de le croire. Cette utilité perçue peut d’ailleurs s’expliquer de différentes façons :

- La personne peut percevoir qu’il vaut mieux croire dans l’existence des reptiliens. Par exemple en se disant que s’ils existent réellement et qu’on l’ignore, le risque de manipulation est énorme. Le risque inverse (y croire alors qu’ils n’existent pas) peut sembler moins grave.

- La personne peut vivre dans un environnement social où cette croyance est valorisée.

- Les engagements passées de la personne peut rendre très coûteux de changer d’avis.

Cette lecture permet également de comprendre pourquoi certaines personnes vont privilégier des thérapies alternatives et complémentaires (TAC). Ce n’est pas simplement que ces personnes jugent vraisemblable qu’une thérapie X soit plus efficace qu’une thérapie Y. C’est aussi le coût associé à chacune qui va guider ce choix. Par exemple, les TAC peuvent être perçues sans risque d’effet secondaire, plus en phase avec d’autres valeurs alors que le système de santé classique peut être perçu à la solde d’enjeux financiers ou source de discrimination. Des enjeux que l’on pourra juger pertinents.

De ce point de vue-là, il est difficile de considérer qu’un choix est irrationnel. Il est (presque) toujours rationnel à l’aune des enjeux perçus par l’individu. Ainsi, peut-être est-il un peu simpliste d’affirmer que les personnes qui s’opposaient au vaccin anti-covid était des « cons » sans prendre en compte les enjeux qui ont pu traverser ces individus (le manque de transparence, l’angoisse de la pandémie, la peur du contrôle, l’urgence…) comme cela est bien pointé dans la vidéo Le biais et le bruit de Hygiène Mentale (notamment à partir de 23:40) ou dans la série d’article Les gens pensent mal : le mal du siècle du blog Zet-ethique métacritique.

Ce qu’il faut croire et ce qu’il faut faire

Si l’on reprend une définition classique de l’esprit critique (Ennis 1991) « Une pensée rationnelle et réflexive tournée vers ce qu’il convient de croire ou de faire », il est intéressant de considérer séparément ces deux éléments ce qu’il faut croire et ce qu’il faut faire.

J’ai pensé dans un premier temps que ce qu’il faut croire correspond toujours à l’explication la plus vraisemblance alors que ce n’est pas nécessairement le cas pour ce qu’il faut faire. Pour reprendre deux exemples déjà donnés dans cet article, il serait rationnel de croire que mon champignon est probablement comestible et en même temps de ne pas le manger. Donc de croire en une théorie et d’agir en fonction d’une autre. Il serait rationnel pour la femme Cro-Magnon de croire que ce n’est pas un prédateur et en même temps de partir en courant.

Mais à la réflexion, je ne vois pas de raison pour que ce soit nécessairement le cas. Faut-il toujours accorder notre croyance à la théorie la plus vraisemblable ? On peut même trouver des contre-exemples : une théorie en philosophie de l’esprit affirme que la conscience11 n’existe pas ou du moins qu’elle n’existe pas comme on l’entend. Elle serait plutôt une illusion créé par notre système cognitif. Cette théorie s’appelle d’ailleurs l’illusionnisme. Quand bien même il y aurait des preuves solides de sa vraisemblance, j’imagine qu’il en va de notre santé mentale de ne pas trop y croire.

De la même manière, on pourrait aussi penser à la question de l’existence du libre arbitre. Quand bien même il serait plus probable que le libre arbitre n’existât pas, il pourrait être préférable de continuer d’y croire.

Il me semble qu’il n’y a pas de raison qu’il faille en soi croire en la théorie la plus parcimonieuse. Cela nous pousserait à nouveau à faire un bond périlleux à travers la guillotine de Hume. La prémisse « il faut croire ce qui est vraisemblable » est certes très utile la plupart du temps, il me semble que rien ne l’impose dans l’absolu. J’imagine que la plupart du temps il est même préférable de croire en une version approximative, facilement manipulable et transmissible qu’en la théorie la plus parcimonieuse.

Une vision plus globale de la pensée critique

Considérer que les choix et les actions d’un individu ne se base pas seulement sur ce qu’il considère comme étant le plus vraisemblable, ouvre d’autres pistes de réflexions qui peuvent être prolifiques.

Comme on l’a vu dans les exemples précédents, le recours à des TAC ou les discours conspirationnistes ne peuvent plus se réduire à la bêtise ou la méconnaissance de l’individu. Il convient de prendre en compte les enjeux qu’il perçoit autour de ces questions et qui le poussent à adopter tel ou tel point de vue.

Prenons un nouvel exemple : la question du nucléaire civil. Certaines organisations s’opposent au nucléaire en évoquant le danger qu’il représente (déchets, accidents…). Pourtant des sources sérieuses abondent pour expliquer en quoi la sécurité est très bien contrôlée et les risques assez minimes. On pourrait alors perdre son temps à développer en quoi ces discours sont contraires aux meilleures connaissances actuelles. C’est-à-dire restreindre le champ de réflexion de la pensée critique à une simple question épistémique.

Il semble plus riche de considérer plus globalement les enjeux perçus pour comprendre les différentes positions. Les risques liés au nucléaires peuvent être perçus comme particulièrement angoissants : les échelles de temps très longue, les représentations des catastrophes passées, la méconnaissance d’une technologie extrêmement complexe, … Probablement que ces éléments-là peuvent influencer les positions sur le nucléaire au moins autant qu’un seul point de vue épistémique de la question. Le contexte socio-politique dans lequel prend place cette technologie influence donc la représentation que peut en avoir la population : quel contrôle de la part de la population ? Y a-t-il des intérêts privés ou militaires ? Quelle confiance est accordée au gouvernement ?

Il est probable par exemple qu’un système davantage démocratique (transparence et contrôle sur nos choix énergétiques, médias sans conflits d’intérêts, …) pourrait favoriser l’adoption de points de vue plus informés et raisonnés.

Cela ouvre donc d’autres leviers d’action pour la pensée critique : au-delà de considérer simplement un individu, ses systèmes de croyances, ses stratégies argumentatives… on peut questionner et vouloir modifier le champ informationnel dans lequel il baigne et qui influence ses croyances et ses actions. Pour paraphraser Bertold Brecht : « On dit d’un fleuve emportant tout qu’il est irrationnel, mais on ne dit jamais rien de l’irrationalité des rives qui l’enserrent ».

——-

Un grand merci à mes camarades du Cortecs Jeremy Attard, Céline Schöepfer et Delphine Toquet pour leurs relectures attentives et leurs conseils pour la rédaction de ce texte qui est presque devenu un article collectif !