Cet article (2/12) s’inscrit dans une série de douze articles sur la naturopathie rédigée avec la volonté de porter un regard détaillé et critique sur la discipline, et dont vous pourrez trouver le sommaire ici. Il ne s’agit pas de partir en quête d’une vérité absolue, mais d’alimenter des réflexions destinées à éviter de causer ou laisser perdurer des souffrances inutiles, de permettre à chacun.e de faire les meilleurs choix en termes de santé. Dans ce deuxième article, il s’agira de définir les modalités pratiques de la naturopathie.

Au regard du manque d’encadrement de la discipline, les pratiques observées en naturopathie sont très variables. On peut cependant dégager quelques points qui semblent communs à la quasi-totalité des naturopathes, et que je vais détailler ci-dessous.

Les naturopathes reçoivent leurs client.es en consultation individuelle, le plus souvent pour une durée minimale d’une heure. Une consultation est facturée en moyenne entre 50 et 80 euros, mais les tarifs sont très variables, notamment en fonction du lieu d’exercice. A la manière des professionnel.les de santé, les naturopathes mènent une anamnèse : c’est à dire qu’iels posent de nombreuses questions sur les antécédents médicaux de la personne, son histoire de vie, d’éventuels événements marquants, ses pathologies et troubles actuels, ses données de santé de manière plus générale (bilan biologique récent, poids, éventuels traitements en cours…), son activité professionnelle, ses habitudes en terme d’hygiène de vie (sommeil, tabac, activité physique, gestion du stress…), son environnement familial, ses habitudes alimentaires, son état émotionnel etc.

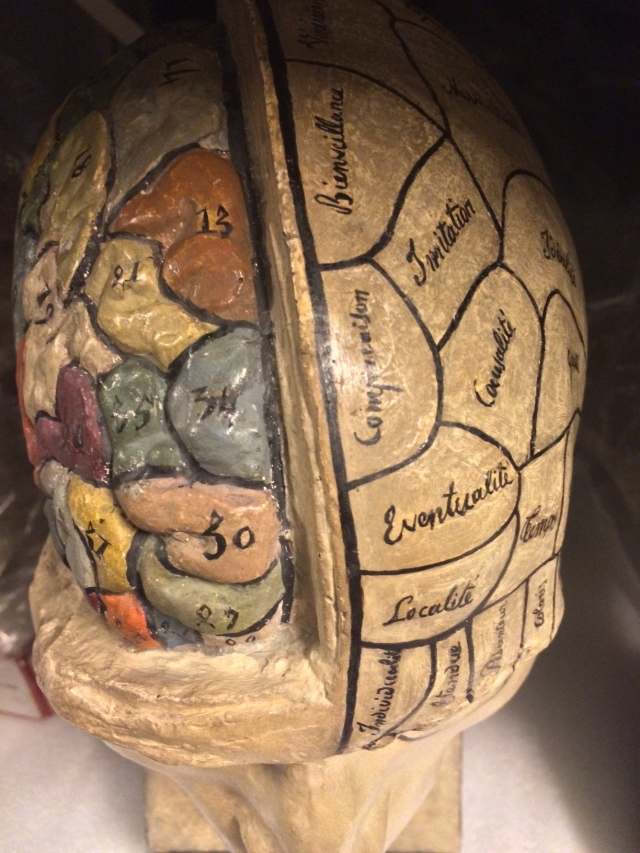

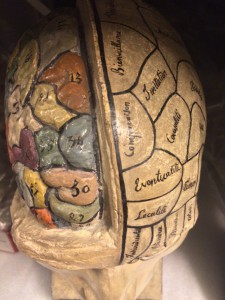

Iels vont aussi tenter d’évaluer la qualité du « terrain » en posant des questions censées donner des informations sur chacun des systèmes principaux de l’organisme (respiratoire, cardio-vasculaire, immunitaire, cutané, urinaire, digestif, hormonal, locomoteur et nerveux) et en observant certains détails de la physionomie de la personne reçue (pilosité, ongles, yeux/iridologie, traits du visage/morphopsychologie…). De ce dernier aspect découle la préférence des naturopathes pour les consultations en présentiel, car iels peuvent ainsi analyser de près leurs client.es.

A l’issue de ce long temps d’échange, où la personne reçue a l’occasion de s’exprimer librement et d’être écoutée (ou bien au fur et à mesure de la consultation), les naturopathes vont formuler des recommandations supposément destinées à préserver ou améliorer l’état de santé de cette personne. Le plus souvent il s’agira de recommandations diététiques (éviter absolument certains aliments, en privilégier d’autres, revoir ses habitudes alimentaires, composer ses repas autrement, changer de lieux d’approvisionnement etc) associées à des recommandations d’hygiène de vie (activité physique, sommeil, tabac…) et des recommandations de compléments alimentaires plus ou moins coûteux (gélules de plantes, minéraux, vitamines, huiles essentielles, probiotiques, complexes détox…). Il est fréquent que des recommandations relevant du développement personnel soient également prodiguées (outils de CNV, pensée positive, PNL…), ainsi que des exercices de gestion du stress (cohérence cardiaque, relaxation de Jacobson, méditation…) et des conseils d’ordre énergétique (exercice des bonhommes allumettes, lithothérapie, techniques réflexes, EFT…).

Les naturopathes étant considéré.es comme les « généralistes » des médecines dites alternatives, il est courant qu’iels renvoient leurs client.es vers des collègues perçu.es comme complémentaires : ostéopathes, sophrologues, kinésiologues, magnétiseurs, chamanes, praticien.nes de médecine traditionnelle chinoise (acupuncture), homéopathes, réflexologues, hypnothérapeutes, géobiologues etc. A moins d’être elleux-même formé.es à ces pratiques, auquel cas les naturopathes peuvent s’auto-recommander pour plusieurs séances supplémentaires…

Habituellement, les recommandations formulées par les naturopathes visent à suivre une logique bien établie, qui présente trois étapes distinctes et qui justifie un suivi régulier :

– En premier lieu, la cure de désintoxication, pour prétendument nettoyer et drainer l’organisme, le libérer des surcharges et toxines accumulées.

– Puis, la cure de revitalisation, supposément destinée à combler les carences et mettre en place des habitudes alimentaires et d’hygiène de vie optimales (c’est à dire qui soient moins sources de toxines et surcharges).

– Et enfin, la cure de stabilisation, censée permettre de maintenir les bénéfices acquis dans les précédentes phases, pour un parfait équilibre physique, émotionnel, et énergétique sur le long terme.

Notons que si certain.es naturopathes sont également professionnel.les de santé (médecins, infirmier.es, pharmacien.nes…), l’immense majorité ne le sont pas et exercent après une formation en naturopathie de durée et contenu extrêmement variables. Et encore, cela n’est pas obligatoire puisque, faute d’encadrement de la pratique, il est possible en France d’installer sa plaque de naturopathe et d’ouvrir son cabinet sans avoir suivi la moindre formation ni obtenu la moindre certification.

Et en matière de formation, on trouve absolument de tout : à distance ou en présentiel, sur quelques week-ends ou sur une année entière, avec ou sans période de stage, avec ou sans contrôle continu, certifiée par la fédération française de naturopathie ou pas, condensée en quelques dizaines de pages de pdf ou en des centaines d’heures de cours… Mais pour avoir eu l’occasion de comparer les enseignements prodigués dans une formation à distance à 69 euros et dans une formation en présentiel à presque 12.000 euros, je peux me permettre d’affirmer que l’essentiel du programme est identique.1

Et pour ce qui concerne la clientèle des naturopathes, un récent sondage nous apprend que 44 % des français.es auraient déjà eu recours à la naturopathie pour prévenir ou guérir des maladies. En tout, 4 % des français.es se soigneraient « principalement grâce à la naturopathie » et un quart jugent cette pratique « autant ou plus efficace que la médecine conventionnelle ».2