Pour certain·es, c’est une évidence : les animaux non humains n’ont pas les capacités cognitives suffisantes pour être sensibles à l’effet placebo. Pour d’autres, les animaux expérimentent l’effet placebo au même titre que les humain·es. Mais la réalité n’est-elle pas plus complexe ?…

Un argument courant des pseudo-médecines

En travaillant sur la naturopathie animale, je suis tombé·e sur un argumentaire couramment employé pour défendre l’efficacité supposée de l’homéopathie, de l’acupuncture et d’autres techniques de soins non éprouvées : les soins énergétiques seraient efficaces, car ils fonctionneraient sur les animaux non humains qui, eux, ne seraient pas sensibles à l’effet placebo.

Or, je me suis rappelé·e avoir lu et entendu à maintes reprises dans des contenus produits par des personnes de la sphère sceptique / zététique, que si, les animaux non humains seraient sensibles à l’effet placebo. Le plus souvent sans plus de détail, ce qui laisse penser que l’effet placebo observé chez les animaux serait comparable à celui des observés chez les humain·es.

Dans un élan de curiosité (et dans le souci de ne pas tirer de conclusions hâtives sur ce sujet que je connaissais mal), j’ai pris le temps de mener quelques recherches sur l’effet placebo chez les animaux non humains. Et le moins que l’on puisse dire, c’est que ce n’est pas un sujet aussi simple qu’il n’y paraît au premier coup d’œil…

Conditionnement et suggestion

La définition de Wikipedia est assez claire :

« L’effet placebo correspond au résultat psycho-physiologique positif (bénéfique) constaté après l’administration d’une substance ou la réalisation d’un acte thérapeutique, indépendamment de l’efficacité intrinsèque attendue du traitement. »

Effet placebo, Wikipedia

Autrement dit, cela signifie que l’on peut observer des effets bénéfiques chez une personne à qui l’on a pourtant proposé une substance (ou un acte thérapeutique) dont on sait qu’elle est absolument inefficace pour traiter la problématique concernée. Cet effet placebo peut aussi être observé en l’absence de placebo (substance ou acte sans efficacité). Cela s’explique en raison de ce que l’on nomme les « effets contextuels ».

Parmi les mécanismes psycho-physiologiques à l’œuvre dans l’effet placebo observé chez les humain·es, on peut citer notamment :

- La suggestion1 : par exemple, le fait qu’un médecin suggère à ses patient·es (sans même leur proposer de traitement) que leur état de santé va rapidement s’améliorer, induit des améliorations plus importantes que chez les patient·es auxquels le médecin n’a pas tenu ces propos rassurants. Un autre aspect du pouvoir de la suggestion peut s’observer, par exemple, lorsqu’un médecin suggère à ses patient·es qu’un traitement placebo aura des effets bénéfiques importants sur leur problématique : cela augmente de manière significative les effets bénéfiques ressentis par ces patient·es.

- Le conditionnement2 : nous serions d’autant plus sensibles à l’effet placebo que nous avons été, par le passé, traités avec des médicaments efficaces, surtout si le placebo est administré sous une forme comparable à celle des médicaments pris par le passé. Ces effets résultent notamment de ce que l’on peut observer dans les mécanismes du conditionnement pavlovien.

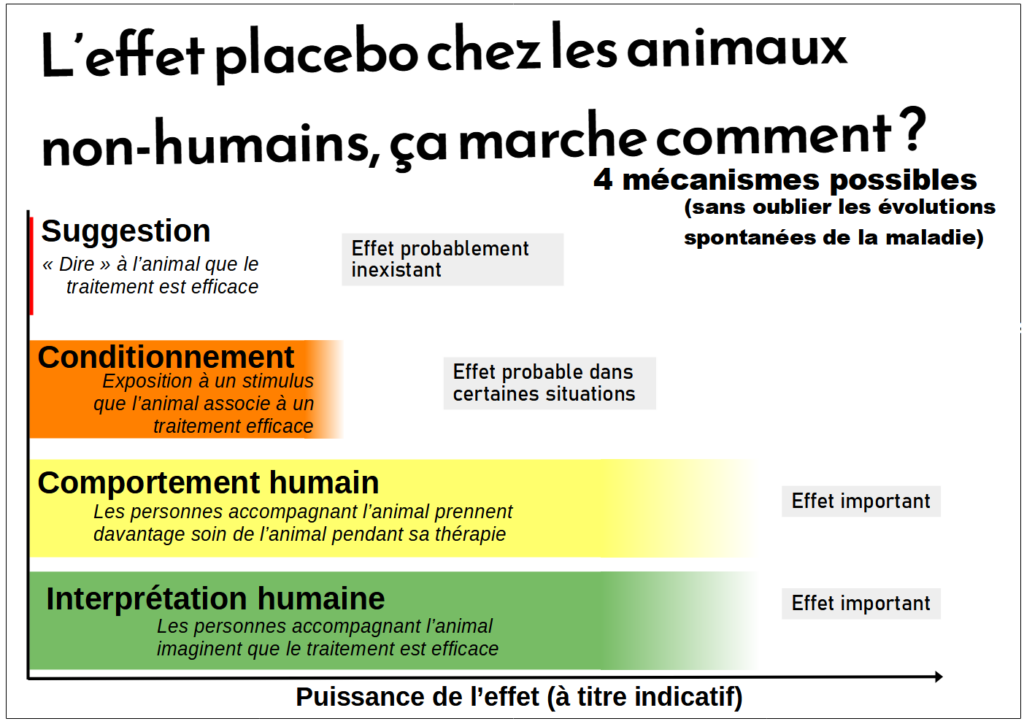

Et chez les animaux non humains alors ? Pour commencer, ils ne semblent pas réceptifs au pouvoir de la suggestion. En effet, il sera probablement vain de chercher à potentialiser les effets d’un traitement administré à un chien, un chat ou un cheval en suggérant à l’animal que ce traitement est diablement efficace, en vantant sa supériorité sur d’autres traitements ou bien encore en valorisant le fait qu’il soit naturel…

Dans de nombres études cependant, on peut observer un effet placebo par conditionnement chez certains animaux : cela a notamment pu être observé concernant la réponse à la douleur, la réponse comportementale, ou bien encore l’immuno-modulation3. Les animaux semblent donc sensibles à l’une des composantes de l’effet placebo : le conditionnement (les chiens de Pavlov, ça vous dit quelque chose?). Ainsi, on peut observer dans certaines circonstances un effet placebo chez des animaux à qui on administre un traitement placebo en même temps qu’on les expose à un stimulus auquel on les a exposés lorsqu’on leur a administré par le passé un traitement éprouvé. Mais à ce sujet, les études sont parfois contradictoires et doivent conduire à la prudence. C’est ce que concluent notamment les auteurices de plusieurs études menées sur l’effet placebo par conditionnement sur la gestion de la douleur chez des rats : leurs résultats se contredisent et les amènent à conclure à la difficulté de penser des protocoles expérimentaux adaptés à l’évaluation de l’effet placebo chez les animaux4. Il serait donc un peu aventureux, en l’état de la recherche, de conclure à l’existence généralisée d’un effet placebo par conditionnement chez les animaux. Difficile en effet de conclure à de tels effets chez toutes les espèces (ce sont surtout les rats qui sont étudiés) et pour toutes les pathologies ou troubles.

Influence humaine

Un autre aspect important à prendre en considération, c’est l’influence du contact humain-animal sur la réponse observée chez un animal domestique à une intervention thérapeutique. Plusieurs études suggèrent en effet que la présence réconfortante d’un·e humain·e, les marques d’affection et de tendresse agiraient positivement sur certains paramètres physiologiques. C’est notamment le cas dans cette étude5 menée sur des chevaux, où les auteurices indiquent qu’ « une séance d’acupuncture ne présente pas plus de bénéfices pour le traitement de l’asthme équin que l’action de caresser les chevaux », ajoutant que « la manipulation et les caresses prodiguées aux chevaux qui sont sévèrement affectés par l’asthme équin apportent un soulagement au niveau de l’obstruction des voies respiratoires, que les aiguilles d’acupuncture soient utilisées ou pas. » (au sujet de l’acupuncture justement, Denis Caroti avait produit un article ici, qui évoque rapidement l’évaluation de l’acupuncture sur des souris)

Mais… ce que l’on observe surtout, c’est un effet placebo indirect, autrement nommé « effet placebo du soignant de l’animal » (« caregiver placebo effect » dans la littérature). Dans des études menées sur des chiens et des chats notamment, une proportion non négligeable de propriétaires et de soignant·es conclut en effet à l’efficacité d’un traitement placebo, en relevant une amélioration nette des symptômes, là où des mesures objectives concluent à une absence d’amélioration de l’état de santé des animaux concernés… Ainsi, les humain·es en charge des animaux domestiques auraient tendance à percevoir des effets inexistants lorsqu’on administre un traitement placebo à leurs animaux. Dans cette étude6 menée sur des chiens atteints d’arthrose par exemple, un tel effet placebo indirect a été observé aussi bien chez les propriétaires que chez les vétérinaires : en effet, environ 40 % des vétérinaires et 50 % des propriétaires ont observé une nette amélioration de la boiterie des chiens traités par placebo, alors que le traitement placebo n’avaient objectivement qu’un effet minime…

Cet effet placebo par procuration peut notamment s’expliquer par le fait que les humain·es sont particulièrement sensibles à divers facteurs qui leur font surestimer l’efficacité réelle d’une thérapie. « Le prix élevé d’une consultation, un diplôme ronflant, un thérapeute à la mode et une longue queue devant le cabinet jouent aussi sur l’évaluation de notre mieux-être consécutif au soin » (dixit Richard Monvoisin dans cet article qui décortique l’effet placebo et questionne la dimension alternative des médecines… alternatives !).

Le principal effet placebo observé dans la prise en charge thérapeutique des animaux ne concerne donc pas les animaux… mais les humain·es !

Que conclure ?

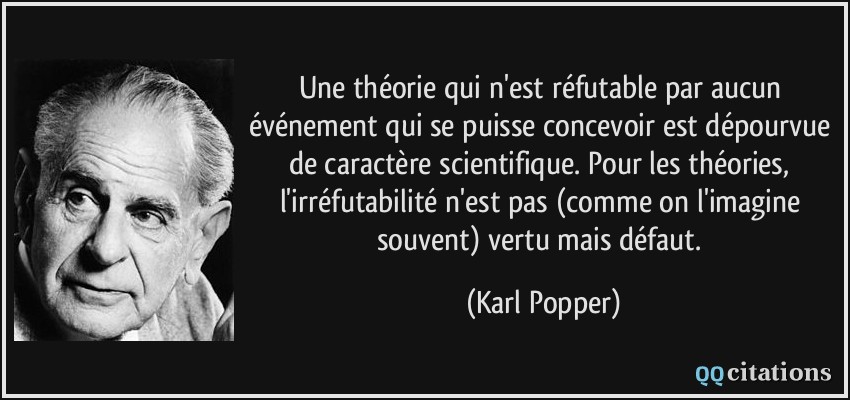

L’ensemble de ces mécanismes peut expliquer les améliorations perçues après des soins énergétiques ou un traitement homéopathique par exemple. Améliorations qui peuvent tenir à l’interaction avec des humain·es bienveillant·es, mais aussi à la perception biaisée que ces mêmes humain·es ont des traitements mis en œuvre… Cette perception risquant d’être d’autant plus biaisée lorsque les personnes impliquées dans les soins sont « engagées » dans des croyances fortes desquelles il serait coûteux de se dégager : on observe que ça fonctionne parce que l’on croit que ça fonctionne, parce que l’on veut que ça fonctionne.

Et même si cela n’est pas spécifique aux animaux, il me paraît important de mentionner deux points importants qui peuvent conduire à conclure (à tort) à l’efficacité de soins non éprouvés (ou à l’existence d’un effet placebo) :

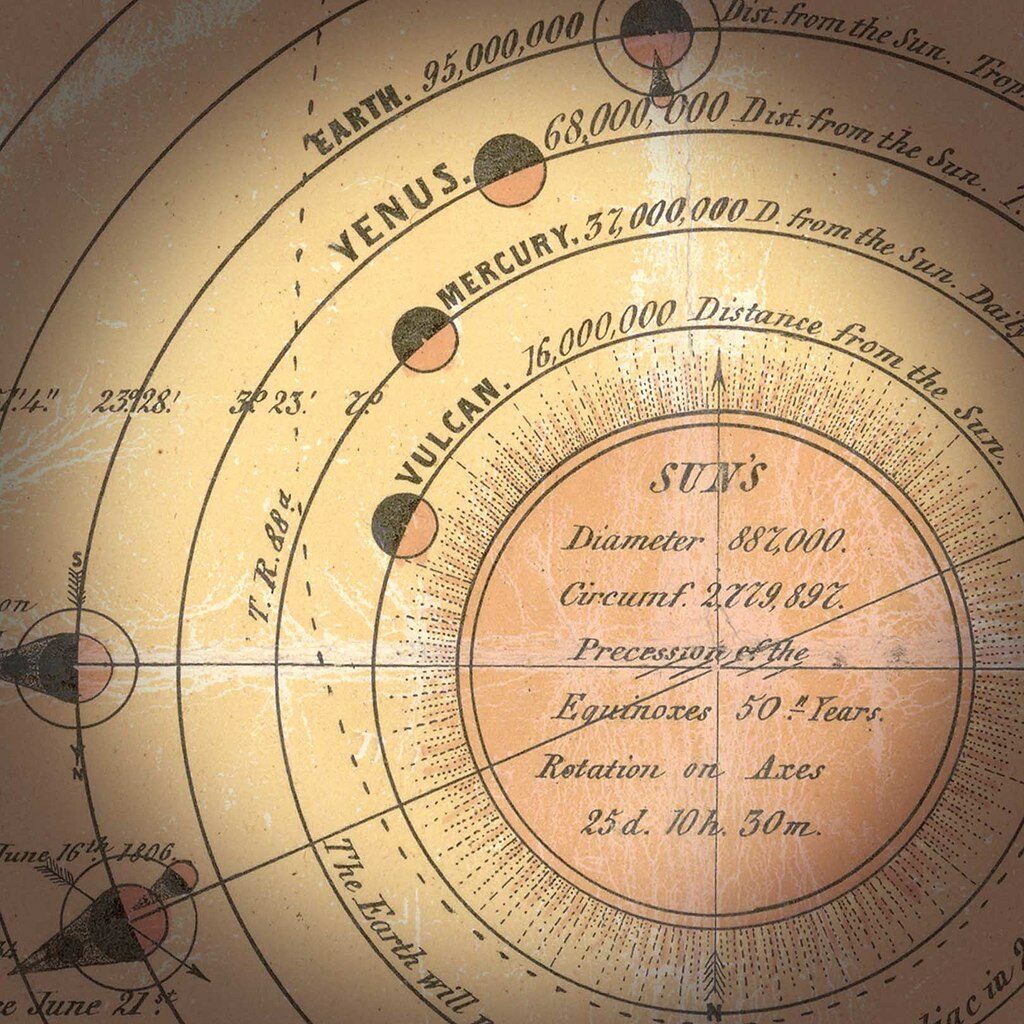

- Le caractère spontanément résolutif de bon nombre de pathologies : ces maladies qui guérissent seules après un certain temps, avec ou sans intervention de notre part. On aurait alors tendance à penser, à tort, que notre intervention est la cause de la guérison, alors que la guérison serait de toute façon intervenue seule dans les mêmes délais (voir l’effet atchoum, ou “post hoc ergo propter hoc”).

- L’alternance de phases de rémission et de poussées aiguës dans d’autres maladies. On pourrait là encore penser à tort qu’un soin est la cause d’une rémission, alors qu’il s’agit de l’évolution naturelle de la maladie.

En bref, l’effet placebo chez les animaux, c’est clairement pas une évidence ! La nuance est de mise et les considérations abordées ici doivent conduire à la plus grande prudence lorsqu’il est question d’évaluer l’efficacité d’un traitement administré à des animaux, que ce soit dans le cadre d’une recherche expérimentale ou dans le cadre du suivi vétérinaire des animaux domestiques.

Pour aller plus loin :

Article – David Ramey, « Is there a placebo effect for animals ? », 25 octobre 2008 : https://sciencebasedmedicine.org/is-there-a-placebo-effect-for-animals/

Article – Brennen McKenzie, « Presentation of placebos on animals », 8 mars 2018 : https://skeptvet.com/Blog/2018/03/presentation-of-placebos-in-animals/

Article – Emily Anthes, « A crucial blind spot in veterinary medecine », 7 novembre 2019 : https://www.theatlantic.com/science/archive/2019/11/danger-pet-placebo/601489/

Vidéo – Brennen McKenzie, « Placebos in pets », 20 novembre 2020 : https://www.youtube.com/watch?v=1QnIKJgpOVg