Les formations proposées par le CORTECS sont souvent l’occasion de faire travailler des étudiant·e·s sur des projets zététiques. Ces dossiers sont de qualité variable : on comprend (et on regrette) que la charge de travail des étudiant·e·s ne leur laisse pas beaucoup de place pour les yétis, les fantômes et autres monstres de la raison. Mais parfois, certains travaux sont très bons et méritent largement d’être rendus publics pour profiter à tout le monde. S’ils ne sont pas infaillibles (mais aucun travail ne l’est) ils font preuve d’une rigueur et d’une démarche critique qui nous semblent satisfaisantes.

Vous trouverez donc sur cette page quelques-uns des meilleurs dossiers produits par les étudiant·e·s des formations zététique du Cortecs en 2022 – 2023. Les premiers proviennent des cours donnés à l’école d’ingénieur ENSEEIHT à Toulouse par Nicolas Martin, les suivants sont issus d’un cours donné à l’Institut d’enseignement à distance en Sciences de l’éducation de l’Université Paris 8 par Vivien Soldé.

Table des matières

Cours à l’ENSEEIHT

Etude de l’influence de la couleur d’éléments sur leur subitisation

[Télécharger ici] Par L. Bahroun, A. Ecorce, N. Bertheloot, N. Groenen

La subitisation c’est la capacité à percevoir le nombre d’éléments dans un ensemble « d’un seul coup d’œil », sans les compter individuellement. Comme les cure-dents dans Rain Man vous voyez. D’ailleurs cette capacité est probablement une légende, et des études montrent que les autistes auraient d’ailleurs de moins bonnes capacité de subitisation 1.

Mais là n’était pas la question. Il s’agissait ici de savoir si la subitisation est plus facile si les éléments à compter sont de couleurs différentes. La taille d’échantillon n’est pas énorme, mais les résultats semble montrer que oui, la bicoloration facilite la subitisation (j’aime bien cette phrase). Une chouette expérience à répliquer et à décliner !

La musicothérapie (et influence de la musique sur la pousse des plantes)

[Télécharger ici] Par T. El Hadi, T. Haas, S. Léostic, D. Zribi

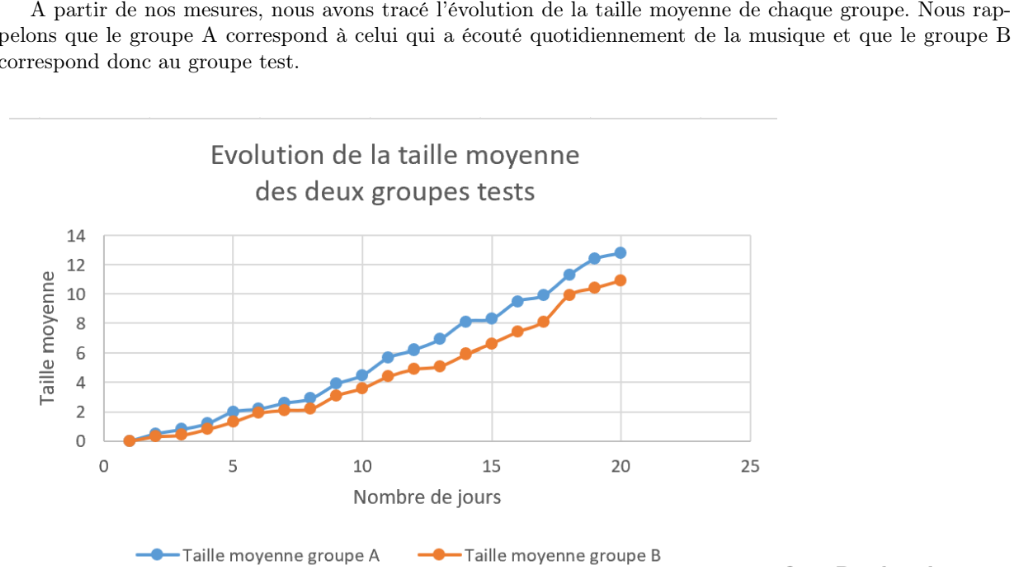

Les cactus poussent-ils mieux en écoutant Jacques Dutronc ?

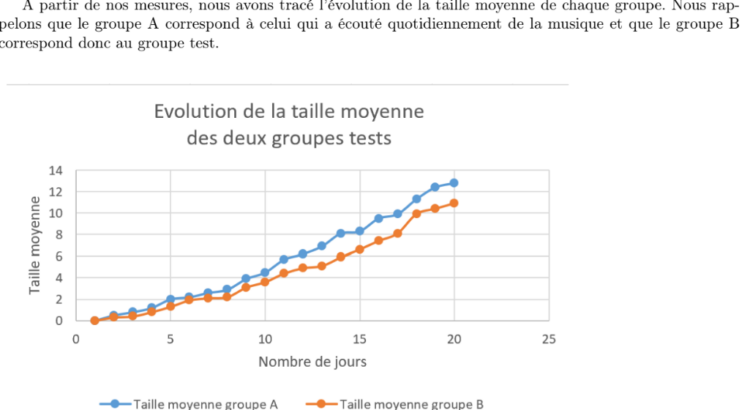

Les étudiants ont dans un premier temps présenté les prétentions et un peu de littérature sur la musicothérapie. Ils ont ensuite voulu voir si la musique influençait la pousse de lentilles. Le protocole est très chouette mais pas parfait (pas de double aveugle, petit échantillon, plusieurs risques de biais) mais il semble que oui les plantes exposées à la nocturne n°2 de Chopin, ont bien poussé plus vite… surprenant ! Reste à essayer de comprendre ce qui a vraiment joué et si ça marcherait aussi bien avec du NTM.

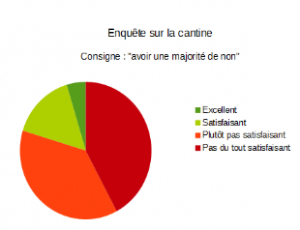

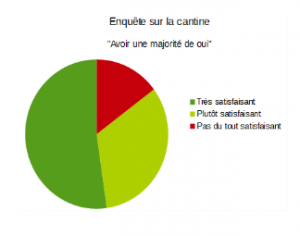

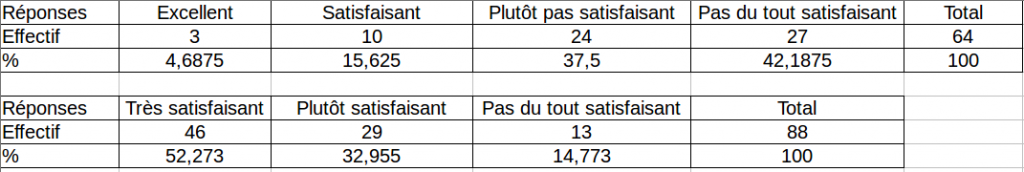

Influence de la construction d’un sondage sur les réponses des participants

[Télécharger ici] Par C. Olivi, A. Wagret et C. Serre

L’ordre dans lequel les questions sont posées dans un sondage peut-il influencer les réponses des participants. On y parle de l’effet entonnoir; de l’effet de contexte logique et de l’effet de contexte sémantique.

Bien que l’analyse statistique aurait pu être plus précise, l’étude semble bien montrer une influence (dans le sens inverse de ce qui avait été prédit). Le recul critique sur l’étude est bien montré.

La génération de l’aléatoire par le cerveau et les manières de l’influencer

[Télécharger ici] Par L. Baldet, B. Berlin, G. Laumonier, M. Lourenco

Le cerveau est mauvais générateur d’aléatoire, on le sait. Si on demande de générer un nombre entre 1 et 10, chaque valeur n’a pas la même chance d’être donnée.

Mais y a-t-il une différence si on demande de penser, de choisir ou de sélectionner un nombre au hasard ? Apparemment oui !

Illusion sensorielle – Effet cutané du lapin (ECL)

[Télécharger ici] Par L. Seugnet, E. Massol, A. Goodwin, S. D’alimonte, E. Norroy

L’illusion cutanée du lapin qui saute est une illusion au nom très marrant et qu’il est vraisemblablement très difficile à observer. Pour ma part, je l’ai longtemps cherchée mais jamais réellement observée. C’est mon big foot à moi. Alors j’ai proposé à un groupe d’étudiant·e·s de partir à sa recherche avec méthode : en fouillant la littérature pour essayer de le mettre en évidence… sans grand succès. Cette illusion serait-elle illusoire ? Le mystère demeure.

Encore un grand bravo à toutes les étudiantes et étudiants et un grand merci : j’apprends beaucoup grâce à vous. Merci aussi à celles et ceux qui ne sont pas ici. On sait que vous aimeriez avoir plus de temps pour parler de yéti et de fantôme !

Cours à l’IED 2 de Paris 8

Chemtrails, analyse d’une théorie complotiste

[Télécharger par ici] par E. Lépine Bazzucchi

Cette étudiante s’intéresse à la construction de la théorie des chemtrails grâce à un

ensemble de documents écrits, photos, audios et vidéos venant du web. Tout au long de ce travail, elle remet en cause ses certitudes, et si les arguments des partisans des chemtrails ne la convainquent pas, certaines ouvertures autour des épandages de pesticides et de la géo-ingénierie la laissent plus dubitative…